3.3.2. La végétation au dernier maximum glaciaire - article

La définition de la période considérée comme étant le dernier maximum glaciaire (LGM, Last Glacial Maximum) a été longuement débattue. Dernièrement, le groupe EPILOG (Environmental Processes of the Ice Age: Land, Ocean and Glaciers 14 ) du groupe de recherche international IMAGES (International Marine Past Global Changes Study 15 ) s'est mis d'accord quant à une redéfinition de la période du LGM. Celle-ci est définie comme étant la période de rétention de glace maximum à l'échelle globale (Schneider et al., 2000a), qui se trouve entre 19'000 et 23'000 ans BP et centrée à 21'000 BP. Cet intervalle de temps couvre la période où les carottes coralliennes et sédimentaires côtières indiquent un minimum du niveau des océans (Fleming et al., 1998).

L'article qui suit présente les cartes de végétation que nous avons construites pour la période du LGM. Il explique également la méthodologie SIG utilisée pour permettre la prise en compte des limites altitudinales dans le choix du type de végétation, et discute des difficultés inhérentes aux reconstructions de végétation. Un effort particulier a été mené pour permettre aux utilisateurs de ces cartes de pouvoir récupérer les images (couleurs ou noir et blanc, avec ou sans identificateurs de catégorie de végétation), ainsi que les fichiers SIG vectoriels (format shapefile) correspondants, et cela pour une étendue globale ou continentale. Nous avons implémenté en Javascript une interface utilisateur on-line permettant une visualisation dynamique de nos cartes et facilitant la récupération de celles-ci par téléchargement. Cette interface est disponible à l'adresse suivante: http://lgb.unige.ch/lgmvegetation/download_page_js.htm.

Les cartes qui suivent ont de plus été intégrées officiellement dans la base de données paléoclimatiques de la NOAA, et peuvent être visualisées dynamiquement avec d'autres données environnementales sur http://map.ngdc.noaa.gov/website/paleo/paleoclimate/viewer.htm.

A GIS-based Vegetation Map of the World at the Last Glacial Maximum (25,000-15,000 BP).

Published online in Internet Archaeology 11, 2001

http://intarch.ac.uk/journal/issue11/rayadams_toc.html

N. Ray1 and J.M. Adams2

1Genetic and Biometry Lab, Anthropology and Ecology Department, University of Geneva, Geneva, Switzerland

2Department of Earth and Environmental Sciences, Wesleyan University, Middletown, Connecticut 06459, USA

Abstract

A preliminary, broad-scale vegetation map reconstruction for use by archaeologists and anthropologists is presented here for the world at the Last Glacial Maximum (18,000 BP, but broadly representing the interval from 25,000 to 15,000 BP). The global LGM map was produced from a range of literature and map sources, and drawn on a GIS with topographic information. Extended coastlines due to LGM sea-level drop were obtained using bathymetric information. The map is available in image and Geographic Information System (GIS) formats, on a global or regional basis.

Accompanying each regional map is a bibliography detailing the principal literature sources of evidence on Late Quaternary palaeovegetation and climates. The maps presented here are merely a preliminary attempt at appraisal of current knowledge and opinion, and future updated versions will be produced as more information on LGM environments becomes available. Nevertheless, together with the accompanying citation summary they should provide a valuable and readily accessible source of information on current opinion in the Quaternary community. It is also hoped that the maps will themselves act as a catalyst for archaeologists to use their own data to contribute to the broader climatic/palaeovegetational picture.

Résumé

Cet article présente une carte globale de la reconstitution de la végétation pour la période du dernier maximum glaciaire (18,000 ans BP mais représentant un intervalle de 25,000 à 15,000 ans BP). La carte a été reconstruite à partir de diverses sources de la littérature (articles et cartes), et introduite dans un Système d'Information Géographique (SIG), accompagnée d'une couche d'information sur la topographie. Les lignes côtières à la période considérée, plus étendues qu'aujourd'hui dû à une baisse du niveau des océans d'environ 120m, ont été obtenues en utilisant des données bathymétriques. La carte est disponible en formats SIG et image, à une échelle régionale ou globale.

Chaque carte régionale est accompagnée d'une bibliographie détaillant les principales sources de la littérature sur la paléovégétation et le paléoclimat du Quaternaire tardif. Les cartes présentées ici peuvent être considérées comme une évaluation des connaissances et opinions du moment, et des versions mises à jour seront produites lorsque de nouvelles informations sur les environnements au dernier maximum glaciaire seront disponibles. Néanmoins, avec les références qui les accompagnent, ces cartes devraient fournir une source d'information pertinente et immédiatement accessible sur les opinions actuelles de la communauté du Quaternaire. Elles agiront aussi, on l'espère, comme agents catalyseurs afin que les archéologues contribuent, de par leurs données, à une meilleure compréhension des informations paléoclimatiques et paléovégétales.

Keywords: VEGETATION, GLACIAL MAXIMUM, HUMAN ECOLOGY, TOPOGRAPHY, GIS.

1. Introduction

In archaeology and anthropology there is now a great deal of interest in the global climate fluctuations which have occurred repeatedly over the last 2-4 million years, during the Quaternary period. In part, this interest reflects the hope that better understanding of the Earth's recent past will allow improved prediction of future human effects on the environment. There is also a great deal of purely academic curiosity amongst archaeologists, anthropologists, ecologists, climatologists, and biogeochemists about the ways that the global environment has changed during the recent past, and the way in which each aspect of the global system has interacted with others. In archaeology, it is becoming increasingly clear that it is necessary to include the study of the shifting climatic and ecological background if an understanding of the behaviour and movements of peoples is to be reached. A great deal of interesting work has begun to appear as a result of taking an 'environmental' approach to human evolution and history (e.g. work by Ortloff and Kolata 1993; Wright 1993, Steele J et al. 1998, Anderson and Gillam 2000). Yet archaeologists and anthropologists, together with other Quaternary scientists, have difficulty obtaining the basic background information that exists in such a scattered form throughout the literature.

To make this task easier, and to aid understanding of how the Earth has changed since the peak of the last ice age (and the main sources of evidence for deducing these changes) around 18,000 radiocarbon years ago (or around 20,000-21,000 calendar years ago, allowing for the relative changes in 14C abundance), we present here a set of maps depicting the world's changing vegetation cover on a region-by-region basis. The maps were compiled by the authors, based on modification and improvement of the earlier Quaternary Environments Network (QEN, http://www.soton.ac.uk/~tjms/adams1.html) vegetation maps (Adams and Faure 1997).

There remains considerable room for disagreement about the history of certain parts of the late Quaternary world. The maps presented here certainly cannot be regarded as the definitive work on the subject: instead they represent a necessary step in the process of assembling data and opinion from the many scientists who work on vegetation reconstruction. Anyone using these maps is urged to consult the description of methods presented in the following pages, to get some idea of the uncertainties that remain. Certain aspects of the maps remain to some extent controversial and they represent the views of the authors, not necessarily those of individual (although we have encountered broad support, and have made effort to consider the advice of every participant). Some marked disagreements in approach and overall conclusions were evident amongst the scientists who contributed to the Network, but despite a few wayward voices, a striking overall consensus was present.

As well as providing a ready source of information for archaeologists, we also hope that our maps may prove useful to those within the Quaternary palaeoecology community. As a coherent map of global vegetation for a particular interval in the past, it should act as a baseline for further work in vegetation reconstruction - even if only as a target for criticism.

2. The Last Glacial Maximum (LGM)

Although time is, of course, a continuum, it has been necessary here to concentrate the reconstructed scenarios around a particular slice of time, the Last Glacial Maximum (LGM), that seems particularly significant in relation to the processes taking place in the global system. We feel that the particular choice of this time slice here is likely to coincide with the interests of many others in archaeology, anthropology and palaeoecology. Other time slices such as the Younger Dryas (approx. 10,800-10,200 14C years ago) are of similar interest, and we plan on producing updated maps in electronic format for different time slices in the near future (earlier maps are available as images at the QEN website http://www.soton.ac.uk/~tjms/adams1.html).

The LGM time-slice is placed at around 18,000 years ago in radiocarbon years. It is now thought that 18,000 years ago in radiocarbon terms corresponds to about 20,000-21,000 years ago in calendar years (Crowley and North 1991). We can consider, however, that the LGM sensu stricto is representative of the broader interval from 25,000 to 15,000 BP, during which climate was very similar in most areas. In this paper, our LGM maps refer to this slightly broader time interval, the LGM sensu lato.

The LGM is seen as the stage during the last glacial cycle at which the greatest mass of ice was present on Earth, showing up in ice cores and carbonates as a peak of 18O (Crowley and North 1991). It is also thought of as being the time at which other components of the ocean-atmosphere system were at their most 'glacial' (e.g. lowest global temperatures, lowest atmospheric C02 concentration, and apparently greatest aridity in many continental regions). In fact, there are numerous signs that not all attributes and processes reached their peak of 'glaciality' (in the sense of maximum cold, maximum ice extent, and maximum difference in water balance relative to the present) at exactly the same time during the last glacial phase; for example Colinvaux (1987) suggests that the lowest temperatures and maximum glacier extensions in tropical uplands may have occurred several thousand years before those at higher latitudes. In contrast, in the mountains of Africa and in the equatorial region of the Far East, at least some glaciers reached their maximum size well after the 18,000 years ago date, at around 15,000 14C years ago (Crowley and North 1991; Markgraf 1993; Street-Perrott and Perrott 1994).

It is important to bear in mind that in some areas for which there is continuous well-dated evidence, climates only a few thousand years before or after 18,000 radiocarbon years ago can be shown to have been quite different from the LGM itself, often being much moister. The LGM phase was relatively brief (lasting for perhaps 2000 calendar years, and depending on the precise definition that one is using) and only the most extreme part of a globally cold and dry phase.

3. Methodology

3. 1. A top-downwards approach

Throughout the process of putting together the LGM map, the emphasis has been on a pragmatic top-downwards approach. Regional experts are consulted on the basis of their own published reviews and maps; these experts discuss the problems and uncertainties in the evidence with the authors, and recommend key paper for them to read. The authors then return to each contributor in order to check that what has been written in the database is factual and reasonable. More extensive description and discussion of the methodology used here can be found in Adams and Faure (1997).

In summary, the LGM map is based on the following sources of data:

Plant fossil data:

Plant fossil data (macro- and micro-), the most direct and trustworthy source of information on past vegetation, are still very patchy for around the time of the Last Glacial Maximum, some 18,000 radiocarbon years ago. Because plant fossils can sometimes give a misleading picture of the local vegetation, due to biases in preservation (Adams and Faure 1997), it is necessary to supplement this information with other sources.

Proxy data sources: zoological and sedimentological information:

Many other sources of data that can serve as proxy indicators of past vegetation cover and structure. Particular species of animals are found to be strongly associated with particular vegetation conditions in the present world, so their fossils can be used as a rough indicator of the ecology of an area in the past.

Sedimentological processes are often dependent on vegetation cover, either in the area where the sediment is being deposited or the area from which it is being eroded. A particular sediment grade or type of depositional structure can often give clues as to the type of vegetation that once existed there, although it is possible to be misled by processes in the past giving the same result by different means.

More tenuously and controversially there are biogeographical clues based on the present day distributions of animals and plants, which may be partly a legacy of the changed vegetation and climate conditions which existed during recent glacial phases, although not necessarily the most recent one. Generally, present-day biogeographical evidence must be regarded as taking lowest priority because it is the most ambiguous and the least direct. Here in the debate that has given rise to the maps, biogeography has been used only to back up or dispute patterns suggested on the basis of palaeoenvironmental evidence, not as a primary source of ideas and opinions.

The approach used to produce the initial QEN maps and the maps presented here is thus highly interdisciplinary, in contrast to most previous attempts at broad-scale vegetation reconstruction for the Holocene and Last Glacial Maximum.

The problems of dating the evidence

An additional problem is that accurate dating is often lacking from deposits of palaeoenvironmental significance. This is especially so for well-oxidized or terrestrial sedimentary deposits such as sand dunes where there is little surviving organic matter that can be used for 14C dating. Fortunately the range of direct and correlative dating techniques is expanding (for instance, optical dating of the quartz in sand dunes is now becoming widely used), and the accuracy of existing methods is also improving. Nevertheless, many sites which have been taken as revealing conditions under the Last Glacial Maximum remain poorly dated or even totally lacking in any real dating control. Obviously, such sources of evidence must be treated with more caution than those which have been thoroughly dated, and the decision whether to accept them or not is ultimately subjective and, of course, potentially clouded by one's own preconceptions of what past conditions were like. The editors have, for the most part, left these difficult decisions to local experts who have themselves studied the Quaternary geology of each area, and have drawn the map boundaries on the basis of their detailed advice.

The drawing of geographical boundaries in relation to climate

In all published palaeovegetation maps based on point sources of data, extrapolation or interpolation based on knowledge of present-day vegetation-to-climate relationships have been important. Each piece of data relating to climate or palaeovegetation provides a basis from which to deduce the climate/palaeovegetation for other adjacent areas. To some extent, the maps presented here are based by proxy on the vegetation-climate relationships that individual contributing authors have assumed, and on the pattern by which they feel climate would have varied across the region.

Such factors are difficult to control and to describe, for the authors who contributed to each individual palaeovegetation map often do not themselves state the assumptions which they are using. However, where such information is provided, it is included in the QEN database at the Web site.

The boundary between tropical and temperate vegetation types is reconstructed on the basis of palaeotemperature estimates from various sources. In fact, the precise position of the demarcation of 'tropical' from 'temperate' vegetation is fairly arbitrary if one looks at the problem objectively (see detailed discussion in Adams 1993), but there is no doubt that there is a general gradient in vegetation ecology and composition as one travels away from the equator. It is always necessary to draw the tropical versus temperate line somewhere, and in the maps here the boundary for most tropical vegetation types is set at a coldest mean monthly value of 10 deg. C. This follows the general correspondence between global present day poleward vegetation boundaries and the present day temperature isotherms (e.g. see the Times Atlas (Times 1992) which presents good general maps of both). For tropical rainforest vegetation, a somewhat higher temperature limit of 15.5 deg. C (as the mean temperature of the coolest month of the year) seems to correspond well to the map boundaries drawn by various authors (I. C. Prentice, pers. comm.).

For the boreal-to-temperate transition, a more generalized definition based on the prevalence of cold climate conifers or birch woodland (Betula) is used as the basis for demarcating the boundary, and a similar floristic type of definition is used for tundra as distinguished from temperate steppe.

In drawing the palaeovegetation maps, the general assumption is made that the overall pattern of isotherms remained approximately the same, but that temperature was lowered (for the LGM) or raised (for the early Holocene) by a particular amount in each area. This seems generally reasonable with the exception of certain areas close to ice sheets or where large shelf areas had appeared: all general circulation model (GCM) reconstructions give generally similar qualitative spatial patterns to those existing at present, albeit shifted quantitatively, and that at around the outer boundaries of the tropics the temperature lowering at the LGM was at least 5.5 deg. C (10 deg. F) (e.g. Crowley and North 1991; Broecker 1995). Thus for the majority of vegetation types, the tropical-temperature boundary is moved equatorwards from the present 10 deg. C (50 deg. F) isotherm for the coldest month, to what is presently the 15.5 deg. C (60 deg. F) isotherm. Another important factor to include in extrapolating from scattered data points to produce a palaeovegetation map is the likely pattern of variation in precipitation. From finding evidence of a particular vegetation type having existed at a particular site in the past, it is possible to arrive at a rough quantitative estimate of precipitation for that place. From this it is reasonable to extrapolate the possible pattern of rainfall across a wider area, and to turn this back into an estimate of vegetation cover. If more than one data point is available, it is possible to interpolate between these. Extrapolation/interpolation of past rainfall patterns from proxy data points can be carried out using a numerical model (which may be coupled to a GCM), and although this brings with it an element of consistency, this is no guarantee that the model itself is correct judging by the problems that are evident in many GCM models (see discussion by Crowley and North 1991, Kagan 1995 and Broecker 1995), and a certain degree of scepticism would be healthy.

Here, the approximate relative precipitation patterns are generally assumed to have varied much as today (the present rainfall distribution being taken from such sources as the Times Atlas (Times 1992) and other regional climatological maps), but to have been shifted in amount. The amount by which rainfall shifted is dictated by the indications from regional sources of terrestrial palaeoevidence, except where there is evidence to the contrary. Assuming this, the boundaries of palaeovegetation types are extrapolated across from areas where relevant data have been found, assuming a broadly similar distribution of rainfall maxima and minima to those which occur today. In fact, there is good evidence that even during the LGM, most areas that are relatively moist today tended to be relatively moist during the LGM (even if shifted substantially overall to drier and cooler conditions, they were generally still moister relative to their surroundings). Hence, extrapolation along these principles seems perfectly reasonable in most areas (though not all; see the text of the QEN website http://www.soton.ac.uk/~tjms/adams1.html, for exceptions).

Web-based expert consultation as a source of information for the maps.

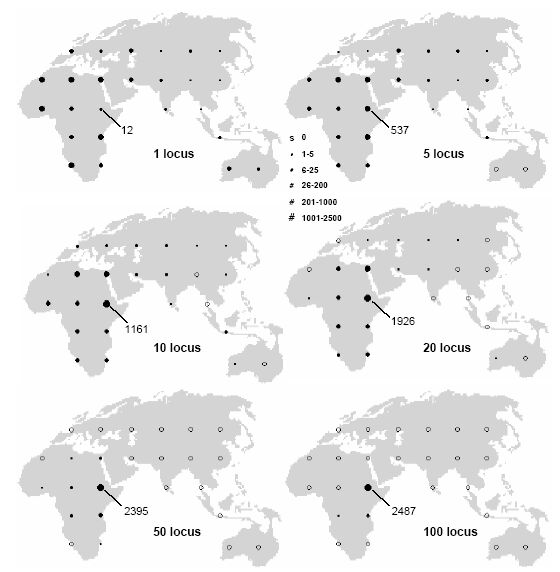

Once the preliminary version of the map was ready, it was made available online for review. Requests for comments on the map were sent out to approximately 20 Quaternary vegetation experts for different parts of the world. The global map was split into six regions, allowing reviewers to easily access their region of specialization. An announcement of the availability of this review page was also made through the QUATERNARY list server (Canadian Research in Quaternary Science, http://www.mun.ca/lists/quaternary/), to ensure a wide targeted audience. This process was very efficient, with numerous valuable feedbacks from palaeovegetation specialists. The comments helped us correct vegetation categories or extensions of certain areas, and revealed various additional literature sources.

3.2. Vegetation map

3.2.1. Digitalization

A first set of hand-drawn maps were digitized and merged in the GIS facility of UNEP/GRID-Geneva (United Nations Environment Program / Global Resource Information Database-Geneva) using the Geographic Information System (GIS) ArcInfo 7.2 (ESRI Inc., Redland, USA). After correction of topological errors with ArcInfo, we exported the file into the GIS package ArcView 3.2 (ESRI Inc., Redland, USA), where the rest of the map production was carried out. Vegetation borders were then directly corrected with ArcView, using the standard digitizing tools. When contours were based on altitudinal zonation or past LGM coastlines, they were altered directly on screen, with the appropriate information in the background.

3.2.2. Key to Vegetation Types

In compiling these maps, we have tried to adhere as closely as possible to the well-known and widely cited scheme developed by Olson et al. (1983). Given the nature of the task we have, however, merged some categories and added others, including some vegetation types for the past that have no close analogue in the present world.

A key to the vegetation types under which the data are categorized can be found in Table 1. The coding numbers correspond to the numbers on the regional maps. A brief description of the physiognomy of each vegetation type is given, together with the nearest corresponding vegetation type(s) on the global ecosystems map and carbon storage database of Olson et al.(1983). Finer subdivisions of vegetation type were not mapped onto our global map, as we feel that there is presently insufficient information to allow such subdivision to be used.

3.2.3. Expressing the uncertainties in the vegetation map reconstruction

It is difficult to relay any simple measure of the amount of confidence to be placed in the patterns of vegetation distribution drawn onto the maps presented here. It has been necessary here to weigh up each case according to which of the cited authors and contacts presents the most convincing set of evidence and arguments. The justification for presenting any particular vegetation reconstruction in the maps is a complex and subtle process (which can be best understood by studying the discussions in some of the individual source papers, or the on-line QEN database, http://www.soton.ac.uk/~tjms/adams1.html).

3.3. Altitudinal zonation

We used the topographical data sets GTOPO30 at 30 arc-sec resolution (about 1 km at the equator) from the US Geographical Survey (http://edcdaac.usgs.gov/gtopo30/gtopo30.html) as the basis for our altitudinal contours. All the individual tiles, less the ones from Antarctica, were merged together using the tools available in the ArcView extension 'Spatial Tools' (Hooge 1999). The global data set was then resampled to a lower resolution of 10 km, by using the standard ArcView resampling tools. This allowed an easier handling of the data. A simple reclassification of this data set allows us to highlight the desired altitude range, which is then vectorized by creating polygons by hand in ArcView. To ensure that this lower resolution did not significantly affect the borders of the vegetation zones, we made several tests consisting of the same manipulation with the original resolution. These tests showed that a resolution of 10 km gives similar results, which was acceptable, especially when recalling the very subjective nature of these maps, and the uncertainties of border locations.

Altitudinal vegetation zones were substantially lower at the LGM than at present, due mainly to the cooling relative to the present, which is evident in all parts of world. These differences will be described in detail for each region, but in general it seems that altitudinal zones were approximately 500-1000m lower than at present. The cooling, and the lowering of altitudinal zones, was most dramatic in the mid- and high- latitudes, where most areas beyond 50 degrees north would probably have had no vegetation above 500m. In the tropical latitudes, the shift in vegetation zones was less drastic, but still involved a change of the order of hundreds of meters. In effect, the lower montane zone of tropical mountains spread out into the tropical lowlands, as indicated by the abundance of montane trees in lowland vegetation at that time (e.g. Hooghiemstra 1989; Behling 1998).

| Tabl. Art. 1. : Vegetation categories and their description |

| ID# |

Vegetation Type |

Description |

Corresponding Olson's vegetation type |

| 1 |

Tropical rainforest |

Broadleaved, tall, evergreen forest. Drip tips and buttress roots common on trees. |

Main Tropical/Subtropical Forest; Broad-Leaved Humid Forest |

| 2 |

Monsoon or dry forest |

Largely or entirely deciduous closed forest in tropics. |

No Olson analogue |

| 3 |

Tropical woodland |

More open, deciduous woody vegetation (more than 6m tall). Open canopy; less than 60% canopy cover. |

Main Tropical/Subtropical Forest; Dry Forest and Woodland |

| 4 |

Tropical thorn scrub and scrub woodland |

Lower woody vegetation (less than 6m tall), generally open with wide gaps between the bushes/low trees, in frost-free climate |

No Olson analogue |

| 5 |

Tropical semi-desert |

Very open. Between 2% and 10% vegetation cover. Scattered clumps of grass or small shrubs. |

Nonpolar desert or semidesert (Sparse (rocky) vegetation, Other Desert and Semidesert, Cool Semidesert Scrub) |

| 6 |

Tropical grassland |

Greater than 20% vegetation cover. Mainly grassy, very few woody plants (less than 5% cover). |

Tropical savanna or montane; Tropical Savanna and Woodland |

| 7 |

Tropical extreme desert |

Less than 2% vegetation cover. Almost entirely barren. |

Nonpolar desert or semidesert (Sand Desert) |

| 8 |

Savanna |

Greater than 20% vegetation cover, mainly grassy but with 5-20% tree cover. |

Tropical savanna or montane; Tropical Savanna and Woodland |

| 9 |

Broadleaved temperate evergreen forest |

Mainly broadleaved and mainly evergreen trees, closed canopy (> ;60% crown cover). Without drip tips or buttress roots. Frosts occasionally occur |

Mostly mid-latitude broad-leaved and mixed (Woods,Temperate broad-leaved forest), Tropical/subtropical humid forest, Temperate/boreal forest; |

| 10 |

Montane tropical forest |

Broadleaved evergreen trees. Closed forest canopy. Shorter than lowland forests, tending not to have drip tips or buttress roots. |

No Olson analogue |

| 11 |

Open boreal woodlands |

Open woody vegetation (less than 60% canopy cover). Highly frost tolerant trees. |

Northern or Maritime Taiga, subalpine |

| 12 |

Semi-arid temperate woodland or scrub |

Low woody vegetation (less than 6m tall), generally open with wide gaps between the bushes/low trees, in a climate in which frosts occur |

Other dry woods mosaics |

| 13 |

Tundra |

Greater than 2% cover by low shrubs (< ;1m) or grasses in a lowland climate with extremely cold winters and cool summers. |

Tundra |

| 14 |

Steppe-tundra |

A vegetation type widespread during the Last Glacial Maximum, which combined plants of tundra and steppe environments. Probably around 50% ground cover by plants; bare ground abundant but patchy. |

No Olson analogue |

| 15 |

Polar and alpine desert |

Less than 2% ground cover by any species of vascular plant. Cold climate virtually year-round. |

Polar or Rock Desert |

| 16 |

Temperate desert |

Less than 2% ground cover in climate in which frost occurs. |

Cool desert and semi desert types |

| 17 |

Temperate semi-desert |

2-20% vegetation cover in a climate in which frosts occur. |

Cool desert and semi desert |

| 18 |

Forest steppe |

5-20% overall tree cover, often as patches of trees, in a mainly grassy landscape. In lowlands. |

Wooded tundra |

| 19 |

Montane Mosaic |

Complex topographic mosaics of forest, tundra, grassland and montane desert. |

No Olson analogue |

| 20 |

Alpine tundra |

Greater than 2% cover by low shrubs (< ;1m) or grasses in a mountain climate with cold winters and cool summers. |

No Olson analogue |

| 21 |

Subalpine parkland |

5-20% overall tree cover, often as patches of trees, in a mainly grassy landscape. |

Cool grassland/scrub. Subalpine. |

| 22 |

Dry steppe |

Greater than 20% vegetation cover, mainly grasses. Relatively short < ;75cm) grasses, drier climate. |

Cool grassland/scrub. |

| 23 |

Temperate steppe grassland |

Greater than 20% vegetation cover, mainly grasses. Relatively tall grasses and other plants (> ;75cm), moister climate. |

Main Grassland or shrubland; Cool grassland/scrub |

| 24 |

Main Taiga |

Conifer forest with a fairly open canopy |

Mostly taiga and other conifer; Main Taiga |

| 25 |

Lakes and open water |

Year-round open water, possibly freezing in winter. |

Water Bodies |

| 26 |

Ice sheet and other permanent ice |

Year-round ice or snow on surface. |

Ice |

| |

The corresponding vegetation type(s) from Olson et al. (1983) are also indicated.

Tropical altitudinal zonation:

The following altitudinal zones were used everywhere in the tropics between 22 degrees North and South of the Equator, on the basis of various reviews of LGM vegetation in the tropics (e.g. Behling 1998):

In areas where tropical forest of some sort is reconstructed from palaeoevidence as being present in the lowlands, the upper limit of tropical lowland forest is designed as 500m above present sea level. Montane forest is present is in the interval 500-2000m. Tundra is in the interval from 2000m to 3500m. Alpine desert, perennial snow or ice is present above 3500m.

All these vegetation zones are lowered some 500m (Hope 1987; Hooghiemstra 1989; Behling 1998) from the present-day vegetation zonation.

Higher-latitude zonation:

-

For the zones 22 degrees-30 degrees North or South of the Equator: upper forest limit (if forest is present in lowlands) is at 1200m. Regardless of lowland vegetation tundra is present in the interval from 1200m to 2000m. Montane/polar desert is present beyond 2000m, unless specific evidence suggests the presence of an ice cap (Hooghiemstra 1989; Hope 1987).

-

We placed the LGM upper forest line in the latitudinal band 30 degrees North to 45 degrees North at 800m. We put 'tundra' vegetation above 800m (e.g. Yu et al. 2000).

-

All areas above 500m altitude, and north and south of 50 degrees, were labelled as alpine/polar desert, unless regional evidence suggests an ice sheet. This is based on the general assumption that in the high latitudes, greater cooling superimposed upon the background cooling due to ice age conditions would eliminate montane vegetation. However, the use of the 500m upper vegetation limit is preliminary, covering a very broad latitudinal band in which temperature certainly varied considerably, and may need to be revised on the basis of reconstructed summer temperatures on a more regionally specific basis. Since no forested areas are recorded from the LGM beyond 50 degrees North and South, no upper forest limit is ascribed.

In specific regions (e.g. in the western USA) where a more complex altitudinal mosaic was clearly present, refinements to the scheme were added. These are described in the regional sections.

3.4. LGM extended coastlines

Due to the extent of the ice sheets during LGM, coastlines were dramatically changed in certain areas due to the drop of sea-level. Based on coral cores, a common accepted mean value for this drop is about 120 meters (e.g. Fairbanks 1989), even thought this change was locally higher or lower, due to the glacio-hydro-isostatic contributions to sea-level (Lambeck and Chappell 2001).

To our knowledge, there is no available global map of LGM coastlines. Most authors mapping LGM environments have used bathymetric data sets to reconstruct the shorelines of the area of interest based on the accepted sea-level drop value of 120 meters. We used the global sea-floor topography data set (version 8.2, http://topex.ucsd.edu/marine_topo/mar_topo.html), compiled by Smith and Sandwell (1997). The data set is at 2 arc-min resolution (about 4 km at the equator). Since the data set was originally in the Mercator projection, we used standard ArcView tools to reproject the data set to geographic projection. For a more convenient use, we also changed the original extent of the data set (0 to 360 decimal degrees) to -180 to +180 decimal degrees. A simple legend reclassification of the values highlights the 120 meters depth contours (Figure 1), allowing to modify accordingly the vegetation boundaries.

Fig. Art. 1 : LGM extended coastlines (sea-level drop of 120m) computed from global bathymetry

(Smith and Sandwell, 1997)

Fig. Art. 1 : LGM extended coastlines (sea-level drop of 120m) computed from global bathymetry

(Smith and Sandwell, 1997)

This contour map was compared with a recent map of South-Eastern Asia that was compiled from a wide array of sources, taking into account tectonic information when available (Voris 2000). Unfortunately, this map was not available in electronic format, so we were not able to compare the differences within the GIS system. However, a simple visual comparison showed only few areas were the differences between the two maps were noticeable at this scale. These differences were relatively small, in the order of 20-50 km. This encouraged us in the view that the global bathymetric data set is appropriate to generate a global map of past coastlines when one accepts the approximation inherent to this approach.

We thus corrected our initial vegetation map to fit these LGM coastlines using the standard digitizing tools in ArcView.

3.5. GIS database

The map was digitalized in geographic projection, which simply takes latitude and longitude as coordinates on a flat surface. This ensures easier conversion into any other specific projection. The drawback is that distance and surface are increasingly exaggerated as we move toward high latitudes, which gives a biased view of vegetation schemes in these areas. The adequate projection depends on the scale and the extent of the area of study (global, hemisphere, continental, regional, etc.), and on the spatial analysis that are to be done (distance or area computation, least-cost paths analysis, etc.). Numerous authors have recommended specific projections depending on the tasks to be achieved. Readers can consult the extensive literature on the subject to find recommended least-distorted projections for specific areas (e.g. Bugayevskiy and Snyder 1995; Steinwand et al. 1995).

The extent most often used for global map display is -180;+180 decimal degrees. For LGM maps, this has the disadvantage of separating the Bering Strait features into the far western and eastern sides of the map. This is not very harmful for a simple display, but it becomes problematic when one needs a spatial contiguity of that region for dynamic studies (e.g. species replacement, population migrations, etc.). For that reason, the map is also available in an extent that allows for that spatial contiguity, which is -25;+335 decimal degrees.

Vector maps were then exported into ArcInfo GRID raster format (e00) and image (tiff). Besides the global maps, regional maps were also produced in these three export formats. We believe that these various forms of outputs will greatly facilitate the import and the use of the vegetation maps.

The maps are available for download in these various formats from the Download Page at: http://lgb.unige.ch/lgmvegetation/

4. Description of vegetation patterns

4.1. Index to the Regions

This text is divided up on a regional basis, roughly corresponding to traditional notions of 'the continents', although the detailed choice of boundaries for each region is fairly arbitrary. The global map is found in Figure 2, while the legend for the maps is found in Figure 3.

Fig. Art. 2 : Global LGM vegetation map (-180;+180 decimal degrees extent)

Fig. Art. 2 : Global LGM vegetation map (-180;+180 decimal degrees extent)

Fig. Art. 3 : Legend accompanying the maps

Fig. Art. 3 : Legend accompanying the maps

The order of the regional treatment is as follows:

North and central America: includes the U.S.A. along with Mexico and the Caribbean, Canada, Greenland, 'Beringia' and central America;

South America: includes the South American area and the Falkland Islands;

Africa: includes Madagascar, Arabia and the Levant;

Europe: includes the area eastwards to the Urals, and also Asia Minor;

Eurasia: includes northern Eurasia, mostly Russia east of the Urals, southern and eastern Asia, the Middle East, and from the central Asian desert southwards and eastwards to Malaysia/Indonesia;

Australasia: includes Australia, New Guinea and New Zealand.

4.2. North and Central America

In North America, the dominant feature was the presence of a vast ice sheet covering Canada. Forest dominated the eastern USA, but it was more open in character and contained trees adapted to the cooler climates.

Regionally specific altitudinal zones: in the Rockies in the west, altitudinal zones were lowered: For the LGM western USA montane mosaic region, between around 26 and 42 Deg.N the following vegetation zones seem to have predominated: alpine tundra, above 2500m, subalpine parkland of open stands of spruce, pines and fir between 1500-2500m, and scrub/woodland below about 1500m (Tallis 1991).

In the Cordillera region of the western USA, the areas below 500m altitude were 'semi-desert'. Everything below 500m was semi-desert, and scrub in the 500-1500m range. Same for the whole 'desert' area to the south, covering Texas and northern Mexico; if below 500m the vegetation was ascribed to the semi-desert category, above 500m, it was reconstructed as scrub. In the Sierra Nevada of California, the areas above 2000m were labelled as ice (Tallis 1991).

Fig. Art. 4 : North and central America

Fig. Art. 4 : North and central America

Selected literature sources for the region of North and Central America :

Barnosky et al. (1987); Barry (1987); Benson and Thompson (1987); Blum et al. (1994); Cole and Monger (1994); Delcourt and Delcourt (1987, 1991); Denton and Hughes (1981); Dyke and Prest (1986, 1987); Elias (1995, 2001); Forman et al. (1992); Graham and Mead (1987); Harris (1993); Herwitz (1992); Holliday (1987); Hopkins et al. (1982); Nordt et al. (1994); Overpeck et al. (1992); Plummer (1993); Richard (1995); Ritchie (1982); Ritchie and Cwynar (1982); Rochefort et al. (1994); Rosseau and Kukla (1994); Schwalb and Burns (1995); Schweger et al. (1982); Tallis (1990); Tchakerian (1994); Thompson and Mead (1982); Thompson and Anderson (2000); Watts (1980); Watts and Stuiver (1980); Webb et al. (1983); Webb et al. (1993); Wells (1992); Wilkins (1991); Williams et al. (2000); Woodcock and Wells (1990).

4.3. South America

South America was slightly cooler and generally drier than at present. It appears that the Amazonian rainforest was substantially reduced in area (though large uncertainties remain). The Atlantic forest of Brazil was also much diminished. Some desert and semi-desert areas formed in what are presently grassland and scrub zones.

Regionally specific altitudinal zones: 'permanent ice' above 4100m throughout the Andes at the LGM, based on Hooghiemstra (1989).

Fig. Art. 5 : South America

Fig. Art. 5 : South America

Selected literature sources for the region of South America:

Absy et al. (1991); Absy and van der Hammen (1976); Behling (1995); Bonatti and Gartner (1973); (Broecker 1995); Bush 1994); Bush and Colinvaux (1990); Campbell (1989a,b); Clapperton (1993); Colinvaux (1972, 1987); Colinvaux et al. (1988); Colinvaux et al. (1989); Denton and Hughes (1981); de Oliveira et al. 1995); Grossjean and Messerli (1995); Haffer (1969); van der Hammen (1992); van der Hammen and Absy (1994); Heine (1994, 1995); Heusser (1983a,b, 1987); Hooghiemstra (1989); Hooghiemstra et al. (1992a); Irion (1984); Iriondo (1988); Iriondo and Garcia (1993); Latrubesse and Rancy (1995); Ledru (1992a,b); Leyden (1985); Leyden et al. (1993); Markgraf (1989, 1991, 1993); Markgraf et al. (1992); Nelson et al. (1990); Schwalb and Burns (1995); Stude et al. (1995); Suguio et al. (1993); Thomas (1994); Thompson et al. (1995); Villagran (1988, 1990); Wijmstra and van der Hammen (1966).

4.4. Africa

Africa was slightly cooler but much drier than at present. The Sahara Desert and the Namib Desert were both expanded, and in equatorial Africa there was relatively little forest cover.

Regionally specific altitudinal zones: In the eastern part of South Africa: areas above 1000m were labelled "temperate steppe grassland" based on Coetzee and van Zinderen Bakker (1988). In the central part of the Sahara desert, areas above 1500m were reconstructed as 'semi-desert', based on the fact that some winter rains apparently occurred in altitude and maintained scattered vegetation (Faure et al. 1995, p. 79; Leroux 1998; Maley 2000).

Fig. Art. 6 : Africa

Fig. Art. 6 : Africa

Selected literature sources for the region of Africa :

Aucour, Hillaire-Marcel and Bonnefille (1994); Bar-Yosef (1990); Battisistini (1970); Belluomini et al. (1980); Bengo and Maley (1991); Bonnefille and Riollet (1988); Close and Wendorf (1990); Coetzee and van Zinderen Bakker (1988); Colyn, Gautier-Hion and Verhaven (1991); Deacon (1990); Dupont (1993); Dupont et al. (2000); El-Nakhal (1993); Fairbridge (1964); Faure (1984); Gasse (1977); Gasse et al. (1994); Gasse et al. (1990); Giresse et al. (1990); Giresse and Le Ribault (1990); Goodfriend and Margaritz (1988); Hamilton (1982, 1988); Hamilton and Taylor (1991); Hooghiemstra (1988); Hooghiemstra et al. (1992b); Isaar et al. (1989); Jansen (1990); Kortlandt (1984); Lézine (1989); Lézine and Vergaud-Grazzini (1994); Lézine and Cassanova (1989); Livingstone (1980, 1993); Maley (1987, 1989, 1992, 2000); Matima (1991); Mordeckai and Goodfriend (1987); Neumann (1989); Petit-Maire, Sanlaville and Zhong-Wei (1994); Preuss (1990); Ritchie (1994); Roberts (1990); Sarnthein (1978); Schwartz (1991); Scott (1989); Servant and Servant-Vildary (1980); Ssemmada and Vincens (1993); Street-Perrott (1994); Tallis (1991); Tamura (1990); Taylor (1990); Thomas and Shaw (1991); Van neer (1984); Vincens (1991); Walker (1990).

4.5. Europe

Ice sheets covered northern Europe and Scandinavia. Most of the rest of northern Europe resembled semi-desert, with a mixture of tundra and grassland elements (steppe-tundra). In southern Europe, vegetation resembled a semi-desert steppe, with scattered pockets of trees in moist areas.

Selected literature sources for the region of Europe:

Becze-Deak et al. (1995); Bennett et al. (1991); Borsy (1987); Davis (1995); Dawson (1992); Denton and Hughes (1981); Frenzel (1992); Grichuk (1992); Harvey (1984); Hooghiemstra et al. (1992b); Huntley (1988, 1990, 1992); Huntley and Prentice (1993); Kozlowski (1990); Laval and Medus (1989); Laval et al. (1991); Pérez-Obiol and Julià (1994); Sjerup (1987); Soffer (1990); Soffer and Gamble (1990); Starkel (1991); Turner and Hannon (1988); Velichko and Kurenkova (1990); Velichko and Isavea (1992); Wells (1992); Weniger (1990); West (1978); Willis (1994); Willis et al. (2000); van Zeist and Bottema (1988).

Fig. Art. 7 : Europe

Fig. Art. 7 : Europe

4.6. Eurasia

Much of Siberia and central Asia was desert-like, but with some large areas of steppe-tundra (rather resembling semi-desert in most areas). China had relatively little tree cover. The vegetation resembled dry steppe in northern China, with scattered areas of trees in the uplands across southern China (in a predominantly grassland lowland landscape). Japan had an open woodland cover. In south-east Asia, there was much more open grassland and dry forest than at present.

Selected literature sources for the region of Southern Asia:

Agrawal (1988); An et al. (1990); An et al. (1991); Barmawindjaja et al. (1993); Bellwood (1990); Broecker et al. (1988); Caratini and Tissot (1988); Chen and Olson (1990); Cullen (1981); Edwards (1994); Erdelen and Preu (1990); Fang (1991); Frakes and Jianzhong (1994); Gasse and van Campo (1994); Han (1991); Hantoro et al. (pers. comm.); Heusser (1990); Hovan et al. (1989); Hyams (1976); Jarvis (1993); Krinsley (1966); Kuhle (1991); Li and Zhou (1993); Li et al. (1995); Liew et al. (1995); Lin and Liew (1986); Lindsey and Thunell (1990); Liu (1986); Loeffler et al. (1984); Morley (1981, 1982); Morley and Flenley (1983); Ooi et al. (1990); Ooi and Tsuji (1989); Petit-Maire et al. (1994); Pye and Zhou (1989); Reynolds and Kanser (1990); Rostek et al. (1995); Singh et al. (1974); Stuijts et al. (1988); Sukumer et al. (1993); Sun and Chen (1991); Tamuru (1992); Thomas (1994); Thomas and Thorp (1992); Tong and Shao (1991); Tsukada (1988); van Campo (1986); van Zeist and Bottema (1988); Velichko (1991); Wang and Sun (1994); Whitmore (1984); Williams and Clarke (1984); Winkler and Wang (1993); Yang and Wang (1990); Yasuda and Tabata (1988).

Selected literature sources for the region of Northern Asia:

Alexeeva (1995); Baryshnikov and Markova (1994); Dawson (1992); Denton and Hughes (1981); Dodonov (1988); Drozdov et al. (1995); Frenzel (1992); Frenzel et al. (1992); Goncharov (1989); Grichuk (1992); Grosswald (1980, 1995); Kolpakov (1995); Lozhkin and Anderson (1993); Madeyska (1990); Peck et al. (1994); Spasskaya (1992); Sun et al. (2000); van Campo et al. (1993); Velichko et al. (1984); Velichko and Spasskaya (1991); Velichko and Kurenkova (1990a,b); Velichko (1993); Volkov and Zykina (1984).

Fig. Art. 8 : Eurasia

Fig. Art. 8 : Eurasia

4.7. Australasia

Fig. Art. 9 : Australasia

Fig. Art. 9 : Australasia

A large extreme desert zone dominated the central part of the Australia continent, and all areas seem to have been drier and cooler than at present. Forest cover was much diminished. In New Zealand, a large ice cap dominated the South Island, with open grassland in the North.

Selected literature sources for the region of Australasia:

Allen (1990); Dodson et al. (1988); Hess (1994); Hope (1987); van der Kaars (1990); Kershaw et al. (1991); Kershaw (1988); Markgraf et al. (1992); McGlone (1988); McGlone et al. (1993); McTaintish (1989); Nanson et al. (1992); Thom et al. (1994).

5. Suggestions and Comments from Readers

The LGM maps presented here represent the latest stage in an ongoing process (as at 4 December 2001). To take account of newly published evidence, and the advice of those working in the field of LGM environments, the maps are certain to be updated, and we aim to present further updated material on the Web. Any further additions, suggestions or criticisms of the maps, or of the interpretations presented here, should be directed to J. M. Adams or N. Ray. We hope that we have cited the opinions of individual contributors as they had intended, but take full responsibility for any misunderstandings which might arise from these citations.

6. Acknowledgements

The authors would like to thank the reviewers of the map for their helpful comments, and the many people who earlier contributed information and advice to the earlier QEN maps, which were precursors to the present set of maps. We are indebted to Hugues Faure for his many helpful suggestions.

N.R. would like to thank Dominique Del Pietro at UNEP/DEIAEW/GRID-Geneva for access to the digitizer and help for map corrections, at University of Geneva David Roessli for help on the download page and the review of an earlier draft, and Alicia Sanchez-Mazas for her comments.

N.R. was supported by a Swiss National Science Foundation grant No. 31-054059.98.

Download Area: the presented maps are available for download at: http://lgb.unige.ch/lgmvegetation

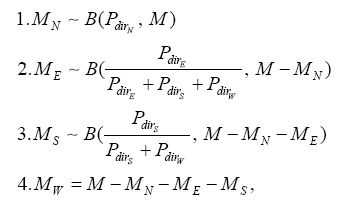

: nombre total de personnes obtenues dans la littérature

: nombre total de personnes obtenues dans la littérature : nombre effectif d'individus

: nombre effectif d'individus ,

,  : nombres de femmes et d'hommes respectivement

: nombres de femmes et d'hommes respectivement : nombre de copies de gènes dans la population pour un locus donné

: nombre de copies de gènes dans la population pour un locus donné

est le temps pour traverser chaque cellule (heure),

est le temps pour traverser chaque cellule (heure),  la longueur d'une cellule (Km), et

la longueur d'une cellule (Km), et  la pente (entre -1 et +1). Cette formule peut être représentée sous forme graphique dans la Figure 3.14. Notons que les pentes calculées avec la technique du maximum moyen sont toujours positives.

la pente (entre -1 et +1). Cette formule peut être représentée sous forme graphique dans la Figure 3.14. Notons que les pentes calculées avec la technique du maximum moyen sont toujours positives.

est le taux de croissance net (

est le taux de croissance net ( ). Pour une population humaine, cette relation peut être envisagée lorsque l'effectif est faible par rapport aux ressources. Lorsque l'effectif augmente, la compétition intraspécifique pour l'accès aux ressources prend de l'importance. En faisant alors l'hypothèse que la croissance est linéairement dépendante de la densité de population, le taux de croissance constant de l'équation (4.1) peut être modifié comme suit (Begon et al., 1996, p. 238):

). Pour une population humaine, cette relation peut être envisagée lorsque l'effectif est faible par rapport aux ressources. Lorsque l'effectif augmente, la compétition intraspécifique pour l'accès aux ressources prend de l'importance. En faisant alors l'hypothèse que la croissance est linéairement dépendante de la densité de population, le taux de croissance constant de l'équation (4.1) peut être modifié comme suit (Begon et al., 1996, p. 238):

est la capacité de soutien. En simplifiant l'expression

est la capacité de soutien. En simplifiant l'expression  par

par  , nous obtenons

, nous obtenons

est donc une combinaison de

est donc une combinaison de  et

et  , et peut être perçu comme la résistance à la surpopulation : plus

, et peut être perçu comme la résistance à la surpopulation : plus  est grand, plus l'effet de la densité sur le taux de croissance est grand. Une modification de l'équation (4.3), suggérée originellement par Maynard Smith et Slatkin (1973), et discutée en détail par Bellows (1981), donne

est grand, plus l'effet de la densité sur le taux de croissance est grand. Une modification de l'équation (4.3), suggérée originellement par Maynard Smith et Slatkin (1973), et discutée en détail par Bellows (1981), donne

1, des interactions sociales permettent de répartir les ressources) ou une compétition de type scramble (b

1, des interactions sociales permettent de répartir les ressources) ou une compétition de type scramble (b  1, utilisation d'un maximum de ressources par chaque individu, sans interactions sociales (van der Dennen et Falger, 1990)). Notons que lorsque

1, utilisation d'un maximum de ressources par chaque individu, sans interactions sociales (van der Dennen et Falger, 1990)). Notons que lorsque  est nul, il y a indépendance envers la densité, et nous retrouvons la croissance exponentielle de l'équation(4.1).

est nul, il y a indépendance envers la densité, et nous retrouvons la croissance exponentielle de l'équation(4.1). (

( ), qui est relié au temps de croissance net

), qui est relié au temps de croissance net  par

par  . L'accroissement de population s'écrit alors

. L'accroissement de population s'écrit alors

constant, indépendant de la taille de la population, de sorte que

constant, indépendant de la taille de la population, de sorte que

est le nombre total d'émigrants au temps

est le nombre total d'émigrants au temps  , et

, et  est la taille de la population dans le dème focal au temps

est la taille de la population dans le dème focal au temps  . Il s'ensuit qu'à l'équilibre, lorsque la capacité de soutien

. Il s'ensuit qu'à l'équilibre, lorsque la capacité de soutien  d'un dème est atteinte,

d'un dème est atteinte,  migrants sont échangés entre le dème focal et ses voisins.

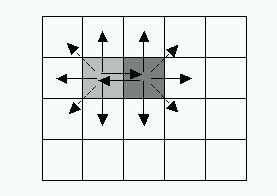

migrants sont échangés entre le dème focal et ses voisins. , qui est la probabilité relative d'une émigration dans un dème voisin

, qui est la probabilité relative d'une émigration dans un dème voisin  (l'indice

(l'indice  variant de 1 à 4). Il y aura donc émigration préférentielle vers les milieux de basse friction, où le mouvement est facilité. Si nous considérons que cette émigration préférentielle est simplement proportionnelle à la friction, nous pouvons écrire

variant de 1 à 4). Il y aura donc émigration préférentielle vers les milieux de basse friction, où le mouvement est facilité. Si nous considérons que cette émigration préférentielle est simplement proportionnelle à la friction, nous pouvons écrire

est la friction du dème voisin

est la friction du dème voisin  .

.  étant une probabilité relative, il s'ensuit que

étant une probabilité relative, il s'ensuit que

) et la probabilité de migration à l'ouest (

) et la probabilité de migration à l'ouest ( ), alors que ce même facteur est de cinq pour le deuxième modèle. Pour ce deuxième modèle, le rapport entre deux probabilités directionnelles est égal au rapport entre les valeurs de frictions relatives correspondantes. Bien que le rapport des probabilités directionnelles soit sensiblement différent entre les deux modèles, les comportements de dispersion sont extrêmement semblables. Nous avons mis cela en évidence par une comparaison des deux modèles sous diverses configurations environnementales (résultats non montrés).

), alors que ce même facteur est de cinq pour le deuxième modèle. Pour ce deuxième modèle, le rapport entre deux probabilités directionnelles est égal au rapport entre les valeurs de frictions relatives correspondantes. Bien que le rapport des probabilités directionnelles soit sensiblement différent entre les deux modèles, les comportements de dispersion sont extrêmement semblables. Nous avons mis cela en évidence par une comparaison des deux modèles sous diverses configurations environnementales (résultats non montrés). au temps

au temps  , noté

, noté  , peut donc s'écrire

, peut donc s'écrire

est égal à 0.25. Les taux de migration et les probabilités directionnelles de migration sont compris entre 0 et 1. Il s'ensuit que les

est égal à 0.25. Les taux de migration et les probabilités directionnelles de migration sont compris entre 0 et 1. Il s'ensuit que les  ne vont généralement pas être des nombres entiers, et nous sommes de nouveau confrontés à la nécessité d'arrondir ces nombres. D'arrondir le nombre à l'entier le plus proche s'est avéré inadéquat. Il existe en effet des cas particuliers où cette technique engendre un nombre total d'émigrants qui est plus grand que le nombre de personnes dans le dème, ce qui peut perturber le processus de coalescence. Une manière simple d'y remédier est de toujours arrondir vers le bas, en tronquant la partie fractionnaire. Le problème, en milieu homogène, est que le nombre total d'émigrants sera alors toujours un multiple de quatre, ce qui peut poser des problèmes dans des applications plus théorique où les petites variations des valeurs de

ne vont généralement pas être des nombres entiers, et nous sommes de nouveau confrontés à la nécessité d'arrondir ces nombres. D'arrondir le nombre à l'entier le plus proche s'est avéré inadéquat. Il existe en effet des cas particuliers où cette technique engendre un nombre total d'émigrants qui est plus grand que le nombre de personnes dans le dème, ce qui peut perturber le processus de coalescence. Une manière simple d'y remédier est de toujours arrondir vers le bas, en tronquant la partie fractionnaire. Le problème, en milieu homogène, est que le nombre total d'émigrants sera alors toujours un multiple de quatre, ce qui peut poser des problèmes dans des applications plus théorique où les petites variations des valeurs de  sont importantes.

sont importantes. ) sur les quatre dèmes voisins en utilisant les déviations binomiales marginales d'une distribution multinomiale. Le calcul des migrants au nord (

) sur les quatre dèmes voisins en utilisant les déviations binomiales marginales d'une distribution multinomiale. Le calcul des migrants au nord ( ), à l'est (

), à l'est ( ), au sud (

), au sud ( ) et à l'ouest (

) et à l'ouest ( ) se passe en quatre phases, selon

) se passe en quatre phases, selon

indique qu'une variable suit une Loi binomiale de probabilité

indique qu'une variable suit une Loi binomiale de probabilité  pour la valeur

pour la valeur  .

. , et que les espérances des

, et que les espérances des  sont égales à ce qui est calculé par l'équation (4.10). Un désavantage de cette solution est qu'elle nécessite le tirage de trois nombres aléatoires pour répartir les émigrants, ce qui peut augmenter très sensiblement le temps de calcul requis pour une simulation. Une simulation ne peut également plus être considérée comme purement déterministe, puisque des petites fluctuations de migrations, et donc de densités, apparaissent à cause des nombres aléatoires.

sont égales à ce qui est calculé par l'équation (4.10). Un désavantage de cette solution est qu'elle nécessite le tirage de trois nombres aléatoires pour répartir les émigrants, ce qui peut augmenter très sensiblement le temps de calcul requis pour une simulation. Une simulation ne peut également plus être considérée comme purement déterministe, puisque des petites fluctuations de migrations, et donc de densités, apparaissent à cause des nombres aléatoires.

est l'asymptote haute,

est l'asymptote haute,  est la valeur de

est la valeur de  pour laquelle la croissance est la plus grande, et

pour laquelle la croissance est la plus grande, et  détermine l'inflexion de la courbe (équivalent au taux de croissance dans la croissance logistique standard).

détermine l'inflexion de la courbe (équivalent au taux de croissance dans la croissance logistique standard). d'émigration du dème focal. La croissance de

d'émigration du dème focal. La croissance de  n'est pas calculée par rapport au temps, comme c'est souvent le cas avec les applications de la croissance logistique, mais au cours de l'accroissement de la taille de la population focale (

n'est pas calculée par rapport au temps, comme c'est souvent le cas avec les applications de la croissance logistique, mais au cours de l'accroissement de la taille de la population focale ( ). Nous pouvons donc substituer

). Nous pouvons donc substituer  par

par  . L'asymptote haute ne peut pas être mise à l'unité, puisque cela signifierait que tous les individus d'un dème peuvent migrer ensemble dans un dème voisin, et cela engendrerait des comportements oscillatoires non réalistes. L'asymptote haute est donc mise à une certaine valeur

. L'asymptote haute ne peut pas être mise à l'unité, puisque cela signifierait que tous les individus d'un dème peuvent migrer ensemble dans un dème voisin, et cela engendrerait des comportements oscillatoires non réalistes. L'asymptote haute est donc mise à une certaine valeur  qui correspond à la fraction maximum d'individus migrants hors de la population. La valeur

qui correspond à la fraction maximum d'individus migrants hors de la population. La valeur  pour laquelle la croissance est maximum (point d'inflexion de la courbe) a été choisie égale à

pour laquelle la croissance est maximum (point d'inflexion de la courbe) a été choisie égale à  , où

, où  est la capacité de soutien de la population focale et

est la capacité de soutien de la population focale et  est la friction de la population focale.

est la friction de la population focale.  joue ici le rôle de retardement du point d'inflexion, en étant codée entre 0 (basse friction, mouvements maximums) et 1 (haute friction, mouvements impossibles). Cela signifie que plus la friction du dème focal est haute, plus les émigrants mettront du temps à sortir 'en masse' du dème.

joue ici le rôle de retardement du point d'inflexion, en étant codée entre 0 (basse friction, mouvements maximums) et 1 (haute friction, mouvements impossibles). Cela signifie que plus la friction du dème focal est haute, plus les émigrants mettront du temps à sortir 'en masse' du dème. d'un individu s'exprime donc par

d'un individu s'exprime donc par

détermine la vitesse de croissance de la probabilité d'émigration. Ce paramètre est néanmoins en conjonction avec

détermine la vitesse de croissance de la probabilité d'émigration. Ce paramètre est néanmoins en conjonction avec  , de sorte que le comportement de la croissance du nombre de migrants est très différent suivant la combinaison des valeurs données à

, de sorte que le comportement de la croissance du nombre de migrants est très différent suivant la combinaison des valeurs données à  et

et  . Pour éviter cela, nous pouvons remplacer

. Pour éviter cela, nous pouvons remplacer  par une valeur dépendante de

par une valeur dépendante de  , par exemple

, par exemple  , où

, où  est un paramètre définissant l'inflexion de la courbe, sans être un taux de croissance à proprement parlé. L'avantage est qu'après avoir trouvé une valeur appropriée pour

est un paramètre définissant l'inflexion de la courbe, sans être un taux de croissance à proprement parlé. L'avantage est qu'après avoir trouvé une valeur appropriée pour  , l'espérance du nombre total d'émigrants

, l'espérance du nombre total d'émigrants  du dème focal peut être exprimée par

du dème focal peut être exprimée par  . Nous avons donc

. Nous avons donc

, définie dans l'équation (4.7). L'espérance du nombre de migrants

, définie dans l'équation (4.7). L'espérance du nombre de migrants  passant du dème focal au dème

passant du dème focal au dème  est alors exprimée par

est alors exprimée par  soit

soit

sont très petites (entre 0 et 2). Selon certaines valeurs des autres paramètres, le nombre de migrants

sont très petites (entre 0 et 2). Selon certaines valeurs des autres paramètres, le nombre de migrants  de l'équation (4.14) est alors presque toujours plus grand que 1. Le fait d'avoir

de l'équation (4.14) est alors presque toujours plus grand que 1. Le fait d'avoir  perturbe grandement la dynamique démographique et doit être évité. La solution trouvée a été d'utiliser un terme de régulation

perturbe grandement la dynamique démographique et doit être évité. La solution trouvée a été d'utiliser un terme de régulation  , exprimé par

, exprimé par

. En ajoutant ce terme à l'équation (4.14) et (4.15), nous obtenons

. En ajoutant ce terme à l'équation (4.14) et (4.15), nous obtenons

): le terme de régulation exponentiel inverse (

): le terme de régulation exponentiel inverse ( ) permet d'obtenir un nombre de migrants plafonné, alors que l'utilisation du terme de régulation simple (

) permet d'obtenir un nombre de migrants plafonné, alors que l'utilisation du terme de régulation simple ( ) aboutit à un nombre de migrants augmentant linéairement. La variation temporelle des capacités de soutien, que nous verrons plus loin au chapitre 4.5.2., peut aboutir à des situations où

) aboutit à un nombre de migrants augmentant linéairement. La variation temporelle des capacités de soutien, que nous verrons plus loin au chapitre 4.5.2., peut aboutir à des situations où  . L'utilisation de

. L'utilisation de  ou de

ou de  comme terme de régulation va alors déterminer comment la densité de population va être ramenée à la capacité de soutien:

comme terme de régulation va alors déterminer comment la densité de population va être ramenée à la capacité de soutien:  va favoriser une régulation par la décroissance logistique intrinsèque (mort des individus), tandis que

va favoriser une régulation par la décroissance logistique intrinsèque (mort des individus), tandis que

ne représente donc pas une variable dont la valeur peut être facilement dérivée de données démographiques. Une manière plus abordable de représenter ce seuil maximum de migration dans ces conditions est d'exprimer

ne représente donc pas une variable dont la valeur peut être facilement dérivée de données démographiques. Une manière plus abordable de représenter ce seuil maximum de migration dans ces conditions est d'exprimer  , ou autrement dit lorsque le dème a atteint sa capacité de soutien. On peut exprimer ce nouveau pourcentage d'émigration (ou taux de migration) par

, ou autrement dit lorsque le dème a atteint sa capacité de soutien. On peut exprimer ce nouveau pourcentage d'émigration (ou taux de migration) par  , car il est équivalent au paramètre

, car il est équivalent au paramètre  du modèle linéaire simple (voir équation (4.6)). Se servant de l'équation (4.19), nous pouvons donc écrire

du modèle linéaire simple (voir équation (4.6)). Se servant de l'équation (4.19), nous pouvons donc écrire

=

=

, le nombre total d'émigrants envoyés en dehors d'un dème, et

, le nombre total d'émigrants envoyés en dehors d'un dème, et  , la densité locale après la croissance logistique (l'indice t+1 signifie que c'est la densité post-logistique), suivaient des lois de Poisson. Pour

, la densité locale après la croissance logistique (l'indice t+1 signifie que c'est la densité post-logistique), suivaient des lois de Poisson. Pour  , l'espérance de cette loi est le nombre déterminé par l'équation (4.6) (pour le modèle linéaire simple) ou l'équation (4.14) (pour le modèle densité-dépendant), alors que pour

, l'espérance de cette loi est le nombre déterminé par l'équation (4.6) (pour le modèle linéaire simple) ou l'équation (4.14) (pour le modèle densité-dépendant), alors que pour  l'espérance de cette loi est le nombre déterminé par l'équation (4.5). La Figure 4.4 donne un exemple d'historique de la densité de population et des nombres de migrants en utilisant le modèle linéaire simple stochastique.

l'espérance de cette loi est le nombre déterminé par l'équation (4.5). La Figure 4.4 donne un exemple d'historique de la densité de population et des nombres de migrants en utilisant le modèle linéaire simple stochastique.

dans une cellule au temps

dans une cellule au temps  est mis à jour par

est mis à jour par

est le nombre de personnes donné par la croissance logistique,

est le nombre de personnes donné par la croissance logistique,  est le nombre d'émigrants et

est le nombre d'émigrants et  est le nombre d'immigrants provenant des cellules voisines.

est le nombre d'immigrants provenant des cellules voisines.

, il y a par définition

, il y a par définition  copies d'un gène donné. Si la population est constante au cours du temps, la probabilité que deux gènes tirés aléatoirement dans la population soient issus d'une même copie à la génération précédente est de

copies d'un gène donné. Si la population est constante au cours du temps, la probabilité que deux gènes tirés aléatoirement dans la population soient issus d'une même copie à la génération précédente est de  . La probabilité de coalescence est donc inversement proportionnelle à la taille de la population. Le temps moyen jusqu'au plus proche ancêtre commun des deux gènes est estimé par l'inverse de cette probabilité, soit

. La probabilité de coalescence est donc inversement proportionnelle à la taille de la population. Le temps moyen jusqu'au plus proche ancêtre commun des deux gènes est estimé par l'inverse de cette probabilité, soit  générations. Pour un échantillon de

générations. Pour un échantillon de  gènes tirés de cette population, nous pouvons reconstruire leur généalogie en les considérant deux à deux (indépendamment des individus). Comme il existe

gènes tirés de cette population, nous pouvons reconstruire leur généalogie en les considérant deux à deux (indépendamment des individus). Comme il existe  paires de gènes différentes, avec chacune une probabilité

paires de gènes différentes, avec chacune une probabilité  de coalescer à la génération précédente, la probabilité totale

de coalescer à la génération précédente, la probabilité totale  pour qu'il y ait une coalescence quelconque à la génération précédente parmi les lignages de cet échantillon est

pour qu'il y ait une coalescence quelconque à la génération précédente parmi les lignages de cet échantillon est

, et sa moyenne est donnée par

, et sa moyenne est donnée par  et est donc égale à

et est donc égale à  . Après une première coalescence, il ne reste que

. Après une première coalescence, il ne reste que  paires de gènes, et le temps moyen pour passer de

paires de gènes, et le temps moyen pour passer de  à

à  lignages est de

lignages est de  . Les temps moyens de coalescence deviennent donc de plus en plus long lorsque l'on se rapproche de l'ancêtre commun. Une discussion plus détaillée sur la coalescence et sur les événements démographiques inférés des arbres de coalescence observés ou simulés, peut être trouvée dans notre article (Ray et al., 2003) présenté au chapitre 4.4.

. Les temps moyens de coalescence deviennent donc de plus en plus long lorsque l'on se rapproche de l'ancêtre commun. Une discussion plus détaillée sur la coalescence et sur les événements démographiques inférés des arbres de coalescence observés ou simulés, peut être trouvée dans notre article (Ray et al., 2003) présenté au chapitre 4.4. jusqu'au dème voisin

jusqu'au dème voisin  . La probabilité

. La probabilité  de cet événement à la génération

de cet événement à la génération  est

est

est le nombre de migrants qui sont arrivés dans le dème

est le nombre de migrants qui sont arrivés dans le dème  puis le dème

puis le dème  à la génération

à la génération  , et

, et  est la densité de population du dème à la génération

est la densité de population du dème à la génération  . Cette probabilité est calculée pour tous les voisins d'un dème (de un à quatre).

. Cette probabilité est calculée pour tous les voisins d'un dème (de un à quatre).

, et pour des données haploïdes (où

, et pour des données haploïdes (où  est le nombre total de gènes présents dans un dème), comme

est le nombre total de gènes présents dans un dème), comme

est le nombre de lignages dans le dème à la génération

est le nombre de lignages dans le dème à la génération  .

.

, nous procédons à une simple interpolation entre les valeurs de capacité de soutien des deux périodes extrêmes. Cette interpolation utilise la valeur de la courbe de température de Vostok au temps

, nous procédons à une simple interpolation entre les valeurs de capacité de soutien des deux périodes extrêmes. Cette interpolation utilise la valeur de la courbe de température de Vostok au temps  comme indicateur de la position relative entre les deux périodes extrêmes. La capacité de soutien

comme indicateur de la position relative entre les deux périodes extrêmes. La capacité de soutien  d'un dème est alors calculée par

d'un dème est alors calculée par

et

et  sont respectivement les capacités de soutien de la végétation présente potentielle et de la végétation au dernier maximum glaciaire, et

sont respectivement les capacités de soutien de la végétation présente potentielle et de la végétation au dernier maximum glaciaire, et  et

et  sont respectivement les valeurs de températures relatives de Vostok au temps

sont respectivement les valeurs de températures relatives de Vostok au temps  et lors du dernier maximum glaciaire.

et lors du dernier maximum glaciaire. d'un dème à un temps donné

d'un dème à un temps donné  par

par

et

et  sont respectivement les frictions de la végétation présente potentielle et de la végétation au dernier maximum glaciaire.

sont respectivement les frictions de la végétation présente potentielle et de la végétation au dernier maximum glaciaire.

grâce au temps courant de la simulation;

grâce au temps courant de la simulation;

, grâce à son altitude relative

, grâce à son altitude relative  (dérivée du fichier bathymétrique), selon:

(dérivée du fichier bathymétrique), selon:

) de la vague de progression en deux dimensions donnent une importance relative similaire au taux de croissance (

) de la vague de progression en deux dimensions donnent une importance relative similaire au taux de croissance ( ) et à la constante de diffusion (

) et à la constante de diffusion ( , analogue à un taux de migration). Dans nos modèles, le taux de croissance et le taux de migration sont donc importants pour la vitesse d'expansion et donc pour le temps de colonisation. Le fait de savoir que le taux de croissance est apparemment plus important que le taux de migration pour la variation du temps de colonisation est important. En effet, si une grande incertitude règne sur l'intervalle du taux de croissance, il ne servirait a rien de vouloir calibrer un modèle en faisant varier d'autres paramètres. Nous reparlerons de cela lors des simulations sur le monde réaliste, dans le chapitre suivant.

, analogue à un taux de migration). Dans nos modèles, le taux de croissance et le taux de migration sont donc importants pour la vitesse d'expansion et donc pour le temps de colonisation. Le fait de savoir que le taux de croissance est apparemment plus important que le taux de migration pour la variation du temps de colonisation est important. En effet, si une grande incertitude règne sur l'intervalle du taux de croissance, il ne servirait a rien de vouloir calibrer un modèle en faisant varier d'autres paramètres. Nous reparlerons de cela lors des simulations sur le monde réaliste, dans le chapitre suivant.

par paire entre les 24 échantillons génétiques de la Figure 4.93 (les indices

par paire entre les 24 échantillons génétiques de la Figure 4.93 (les indices  seront expliqués plus loin). Cet énorme fichier de résultats prend une place mémoire d'environ 600 Mb et il n'est donc pas aisé de travailler avec un tel fichier. C'est pourquoi nous avons développé un programme spécifique, CORRELATOR, pouvant travailler avec ce fichier, et faire les nombreuses étapes de calculs qui vont être expliquées dans les paragraphes suivants. La structure et les paramètres du programme CORRELATOR sont expliqués de manière plus détaillée dans l'Annexe 9.

seront expliqués plus loin). Cet énorme fichier de résultats prend une place mémoire d'environ 600 Mb et il n'est donc pas aisé de travailler avec un tel fichier. C'est pourquoi nous avons développé un programme spécifique, CORRELATOR, pouvant travailler avec ce fichier, et faire les nombreuses étapes de calculs qui vont être expliquées dans les paragraphes suivants. La structure et les paramètres du programme CORRELATOR sont expliqués de manière plus détaillée dans l'Annexe 9. entre les matrices de

entre les matrices de  par paire obtenues pour chaque simulation (qui sont sous forme de deux matrices linéarisées

par paire obtenues pour chaque simulation (qui sont sous forme de deux matrices linéarisées  et

et  ) par le coefficient de Pearson (Sokal et Rohlf, 1981, p. 565), selon

) par le coefficient de Pearson (Sokal et Rohlf, 1981, p. 565), selon

(4.27)

(4.27)

,

,  et

et  .

.

par paire entre tous les échantillons simulés. L'indice

par paire entre tous les échantillons simulés. L'indice  est un indice de fixation indiquant le degré de subdivision d'une population. Il est égal à la corrélation de deux gènes pris dans un dème (ou subdivision) de la population, par rapport à deux gènes pris au hasard dans la population totale (pour une discussion des indices de fixation, voir Excoffier, 2001). Cet indice peut être exprimé en terme de temps de coalescence par (Slatkin, 1991)