Informatique

Internet ou l’introuvable société du savoir

Depuis l’invention du Web, il y a vingt ans, les nouvelles technologies ont profondément bouleversé notre quotidien. Elles ont en revanche eu plus de peine à faire valoir leur potentiel là où on les attendait peut-être le plus: en matière de formation et d’éducation

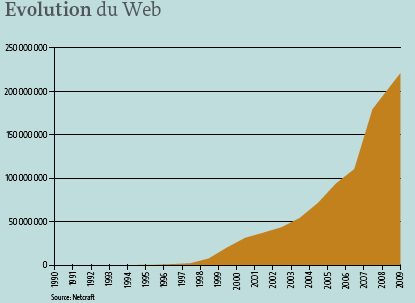

Vingt ans plus tard, Internet est en effet omniprésent (lire ci-contre), sauf peut-être là où on l’attendait le plus. Car si près d’une personne sur cinq est aujourd’hui connectée, la Toile sert surtout à des activités liées aux loisirs ou aux services. On y recourt pour choisir un film ou un restaurant, pour trouver son chemin dans une ville inconnue ou pour dégotter une recette de cuisine. Et, bien sûr, pour communiquer. Globalement, un tiers du temps passé aujourd’hui sur Internet est ainsi consacré au mail, aux messageries instantanées ou aux réseaux sociaux. Une proportion en constante augmentation.

Le numérique, quand et comment?

En matière d’éducation et de formation, malgré un potentiel qui semble énorme, l’usage des nouvelles technologies reste en revanche relativement timide. Mais en quoi au juste l’informatique peut-elle être utile en classe? C’est précisément à cette question que tente de répondre l’Unité des technologies pour la formation et l’apprentissage (Tecfa) depuis sa création en septembre 1989. Cette structure, qui regroupe aujourd’hui une vingtaine de collaborateurs, s’est donné pour objectifs d’identifier quand et comment utiliser le numérique dans les processus d’apprentissage, de trouver le moyen de faire cohabiter les nouvelles technologies avec des dispositifs pédagogiques qui ne sont pas basés sur du numérique, d’évaluer et de maîtriser les outils disponibles sur le marché. A l’heure du haut débit et de l’interface tactile, état des lieux avec sa directrice, Mireille Bétrancourt, professeure à la Faculté de psychologie et des sciences de l’éducation.

«L’accès toujours plus large et toujours plus rapide à Internet a ouvert d’énormes possibilités, confirme la spécialiste. En abattant les barrières spatiales et temporelles, le Web a non seulement modifié la manière dont on interagit avec le monde, mais aussi notre perception du monde, et donc, ce qu’est le monde. Mais pour l’instant, il est vrai qu’on ne sait pas encore vraiment comment faire fructifier cette évolution en classe. Ce qui est certain en revanche, c’est que les nouvelles technologies n’ont pas vocation à remplacer les méthodes d’enseignement classiques du jour au lendemain. A l’école, l’ordinateur n’est pas utile partout et tout le temps.»

Identifier les objectifs

Le credo défendu par les chercheurs de Tecfa consiste donc à avancer progressivement, en cherchant la meilleure manière d’intégrer les ressources numériques aux autres outils disponibles. Pour y parvenir, il faut être en mesure d’identifier clairement les objectifs qui peuvent être atteints au travers du numérique et ceux qui ne doivent pas l’être. «Pour les activités en géographie, par exemple, Google Earth est un outil qui a aujourd’hui énormément de succès dans les classes, complète Mireille Bétrancourt. Si on s’en sert uniquement pour montrer aux élèves que tel pays se trouve à tel endroit, cela n’a pas grand intérêt du point de vue pédagogique. En revanche, si on parvient à intégrer les possibilités offertes par cet outil dans une séquence éducative impliquant également d’autres supports, les résultats peuvent être excellents. C’est à ce type de problèmes que nous réfléchissons depuis deux décennies maintenant.»

Si la question de l’utilité de l’ordinateur en classe n’a pas encore été tranchée, c’est qu’elle est plus complexe qu’on pourrait le penser de prime abord. D’abord parce que tout est allé très vite. Il n’y a pas si longtemps, le fait de pouvoir converser en image et en direct avec quelqu’un se trouvant à l’autre bout du monde relevait en effet de la pure science-fiction. Et, au début des années 1990, lorsque Tecfa a commencé ses activités, Internet en était encore à ses balbutiements et les personal computers commençaient tout juste à se démocratiser.

Lignes vertes et «floppy disc»

«Les premières machines, avec leurs écrans noirs sur lesquels brillaient des lignes vertes, n’étaient pas commodes à utiliser: il fallait taper toute une série de hiéroglyphes pour arriver à faire la moindre opération, se souvient Mireille Bétrancourt. Ensuite, avec les premiers MacIntosh, nous avons été confrontés à des ordinateurs sans disque dur. Il fallait donc changer en permanence la disquette système, c’est-à-dire les fameux "floppy disc". A ce moment-là, il était difficile de prévoir l’ampleur des changements que ces nouveaux outils allaient provoquer. Certaines personnes bien inspirées au sein de l’université ont néanmoins pressenti que l’informatique pouvait devenir, à plus ou moins long terme, un moyen d’enseignement et de formation privilégié. C’est comme ça que nous nous sommes lancés dans l’aventure.»

A l’époque, beaucoup d’espoirs sont encore placés dans le langage Logo. Mis au point au milieu des années 1960 déjà par l’Américain Seymour Papert, chercheur au Massachusetts Institute of Technology (MIT), ce langage de programmation largement inspiré par les travaux de Jean Piaget est spécifiquement conçu pour l’enseignement. Au travers de l’élaboration de «micro-mondes», il a pour objectif d’aider les enfants à progresser dans la résolution de problèmes. Devenue célèbre auprès de millions d’écoliers, son application la plus connue permet de déplacer une tortue graphique sur l’écran à l’aide d’instructions codées.

Ce langage, encore largement utilisé de nos jours en milieu scolaire, a longtemps constitué une piste de recherche importante pour les chercheurs. Bonne base à la programmation, il peut en effet également être utilisé, moyennant la création de nouveaux micro-mondes (on en compte 130 aujourd’hui) à l’approche de nombreuses disciplines comme les mathématiques, la physique ou la robotique. «Logo a permis – et permet encore – d’obtenir de très bons résultats, complète Mireille Bétrancourt, mais, à un certain moment, on a peut-être placé trop d’espoirs dans cet outil : tout d’un coup, on pensait avoir trouvé le moyen de redonner le goût d’apprendre à ceux qui l’avaient perdu. Ce qui n’est évidemment pas le cas.»

Explosion de l'offre

Il faut donc chercher ailleurs. A partir des années 2000, avec l’explosion de l’offre disponible sur la Toile et le développement de la vitesse de calcul des ordinateurs, l’enseignement à distance connaît un important développement. C’est l’époque des «kits d’apprentissage». Une approche qui donne de bons résultats dans le domaine de la formation des adultes, mais qui reste difficile à implanter en classe. «Différents travaux ont montré que lorsqu’on se contente de digitaliser la matière enseignée sans ajouter de plus-value, ce type d’outil perd une grande partie de son intérêt, explique Mireille Bétrancourt. Car, ce qui est crucial, c’est le type d’activités proposées aux participants. Et ces activités, lorsqu’elles sont médiatisées ne répondent plus aux mêmes règles que lorsque l’on est en présence. Il faut donc les penser autrement, davantage les scénariser, en s’appuyant sur une stratégie pédagogique efficace.»

Le problème, c’est que c’est un exercice qui demande du temps. Pas question en effet d’improviser en classe. Avant d’introduire un nouvel outil, il faut être en mesure de le maîtriser parfaitement sous peine de déclencher les quolibets d’une vingtaine de jeunes à l’affût du moindre faux pas.

Ensuite, il faut trouver le moyen d’intégrer ces nouveaux éléments dans une séquence éducative, prévoir la possibilité d’accéder à une salle informatique ou à des ordinateurs portables, etc.

A ce véritable casse-tête s’ajoute le risque de voir tous ces efforts réduits à néant très rapidement étant donné la faible pérennité des produits informatiques. Beaucoup d’enseignants s’étant lancés dans l’aventure informatique à titre individuel ont ainsi été sérieusement échaudés par le fait que l’outil qu’ils utilisaient et auquel ils s’étaient habitués soit soudainement remplacé par une version différente. Ce qui les forçait à tout reprendre à zéro.

Afin de limiter les risques, le Service école et médias du canton de Genève propose depuis peu un catalogue de modules destinés à l’enseignement dont il assure la pérennité et qui peuvent être téléchargés sur Internet. «Aujourd’hui, on peut très bien imaginer que chaque élève passe une demi-heure par jour sur l’ordinateur pour suivre des programmes spécifiques et ainsi combler ses points faibles, commente Mireille Bétrancourt. Les outils sont là, le matériel aussi. Mais cela implique de revoir complètement les dispositifs de gestion de la classe et la manière de penser la scolarité: il faut prévoir non seulement des séances de travail en commun, mais aussi des ateliers et des séquences individuelles. C’est relativement aisé dans le primaire. En revanche, ça l’est moins à partir du secondaire, dans un système fonctionnant avec des tranches de 45 minutes dans lesquelles il faut caser un certain nombre d’allers-retours entre la salle de classe et la salle informatique.»

En plein essor depuis quelques années maintenant, les jeux intelligents ou «serious game» forment également un champ de recherche important pour les collaborateurs de Tecfa. Dans le cas présent, il s’agit de s’appuyer sur une idée vieille comme le monde: profiter du pouvoir addictif et attractif du jeu pour faire apprendre quelque chose. Comme l’ont bien compris les concepteurs de ce type de produits, l’énorme potentiel ludique offert par l’ordinateur constitue en effet un support privilégié pour l’éducation dans la mesure où le jeu suscite un engagement cognitif très intense qui peut aller jusqu’à enlever la perception du temps qui passe. Tout le défi consiste dès lors à parvenir à mettre à profit ces fantastiques capacités de concentration et d’abnégation pour réellement progresser.

C’est précisément là que le bât blesse. «C’est un équilibre très difficile à trouver, confirme Mireille Bétrancourt. Il existe aujourd’hui beaucoup de programmes éducatifs informatiques pour apprendre à compter, à lire, etc. Mais, soit le jeu n’est pas amusant, soit son contenu pédagogique est faible. Car, dans la plupart des cas, les logiciels commerciaux s’arrêtent dès que survient une difficulté. Pour l’instant, il n’y a guère que les "serious games" développés en laboratoire, comme ceux que nous mettons actuellement au point à Tecfa (lire ci-contre) qui parviennent à gérer convenablement ces situations de blocage.»

Enfin, comme le souligne Mireille Bétrancourt, le fait que l’ordinateur offre la possibilité de créer – individuellement ou collectivement – des documents originaux qui peuvent être révisés et partagés à tout moment est également peu exploité dans le monde de l'éducation, alors que c’est une pratique très développée dans le monde professionnel.

Face à ce qui ressemble beaucoup à une impasse, l’avènement des interfaces tactiles (iPad, iPhone, etc.) pourrait bien, une nouvelle fois, changer la donne. Développée dans les années 1980, l’interface graphique (caractérisée par la trilogie souris, clavier, bureau), même si elle a permis des avancées considérables, restait en effet un outil relativement lourd à manier. Ce qui n’est pas le cas de cette nouvelle génération de machines. «Le monde du tactile va nous faire entrer dans un nouveau paradigme, s’enthousiasme Mireille Bétrancourt. En utilisant directement la main pour conduire la navigation, cette technologie permet de faire des tas de choses qui étaient inimaginables jusqu’ici. On devrait par exemple pouvoir utiliser en classe des tableaux blancs interactifs – qui sont au point depuis quelques années déjà mais dont on ne savait que faire jusqu’ici – en complément du bon vieux tableau noir. Il suffirait dès lors de télécharger les applications nécessaires pour pouvoir les intégrer à la leçon. Même si c’est encore de la musique d’avenir, nous nous trouvons sans doute aujourd’hui à l’aube d’une nouvelle révolution.»

«Digital natives»

Un tournant qu’il s’agira de ne pas manquer. Car négliger la place de l’informatique à l’école, c’est prendre le risque d’accentuer le divorce entre cette institution déjà fort malmenée et ceux qui la fréquentent. La plupart des écoliers et des étudiants du monde sont aujourd’hui des «digital natives». Nés après 1990, ils sont baignés dans le numérique depuis toujours et maîtrisent généralement parfaitement ces outils qui effraient tant les plus âgés. Habitués à chercher les réponses à leurs questions sur Google, Wikipédia ou les réseaux sociaux, ils comprennent mal que l’école n’ait pas intégré ces éléments. Conséquence: le sentiment que l’école ne permet pas d’acquérir un savoir utile et l'idée que ce qui leur est réellement nécessaire, ils l’apprendront chez eux ou avec leurs camarades. «Même si cette perception est fausse, conclut Mireille Bétrancourt, cette perte de crédit est inquiétante pour l’avenir et il faut absolument la prendre en compte avant qu’il ne soit trop tard.»

Dépasser la crise par le jeuLes chercheurs de l’Unité des technologies pour la formation et l’apprentissage mettent actuellement au point deux «serious game». Le premier est destiné à des enfants sourds ayant reçu un implant auditif. Le second constitue un support pour les adolescents dont un parent a subi un traumatisme crânien Popularisé par des titres comme SimCity ou The Sims, l’univers des «serious games» génère aujourd’hui un chiffre d’affaires annuel de 1,5 milliard d’euros, somme qui, compte tenu de la très forte croissance du secteur, pourrait atteindre les 10 milliards en 2015. Dans ce qui ressemble encore fort à une jungle, on trouve des jeux consacrés à des thèmes aussi divers que la défense (America’s Army), le marché de l’emploi (Technocity), l’écologie (Ecoville), la politique (September the 12th), l’humanitaire (Food Force, Darfur is Dying), la publicité, la religion, l’art ou la santé. Parallèlement à ces logiciels qui visent un grand public et dont le contenu pédagogique n’est pas toujours irréprochable, il existe des programmes plus spécifiques comme les deux projets basés sur le concept de «serious games» sur lesquels les chercheurs de Tecfa travaillent actuellement. Le premier, réalisé en partenariat avec le Centre romand d'implants cochléaires des HUG, est un programme de réhabilitation auditive pour des enfants ayant reçu un implant cochléaire. Cette intervention chirurgicale, qui peut se faire dès l’âge de 2 ans, permet de redonner l’ouïe à des personnes sourdes de naissance. Cependant, après l’opération, il reste un important travail de réhabilitation à accomplir pour accéder au langage. Soulager les parents «Les séances de logopédie sont naturellement indispensables, explique Mireille Betrancourt, directrice de TECFA. Mais on ne peut pas en suivre tous les jours. C’est beaucoup trop lourd à gérer. Le logiciel de support que nous avons mis au point, et qui est en train d’être évalué, associe des concepts de jeux auditifs largement éprouvés avec des systèmes d’interaction spécifiquement adaptés aux enfants de 2 à 5 ans. Si son efficacité est confirmée, il permettra à la fois de soulager les parents d’une tâche fastidieuse et à compléter le travail du logopédiste.» Réalisé en coopération avec l’équipe de Jean Dumas, psychologue clinicien à la FPSE, le second projet vise à développer une plateforme d’aide et de support pour les adolescents dont un des parents a subi un traumatisme crânien. Ce type d’accident, qui peut avoir des répercussions physiques lourdes, mais aussi engendrer des troubles du comportement et de la personnalité, entraîne souvent un renversement des responsabilités et des rôles familiaux. Une situation qui est susceptible de provoquer des épisodes de dépression chez le patient, mais qui est également difficile à gérer pour les enfants et, en particulier, pour les adolescents. «C’est un âge critique, confirme Mireille Betrancourt. Plus jeune, on ne se rend pas forcément compte de ce qui se passe, plus âgé on dispose de davantage de ressources pour faire face. Par ailleurs, les ados constituent une population que l’on n’amène pas facilement en thérapie. C’est un moment de la vie où il est souvent difficile de verbaliser ce que l’on ressent. D’où l’intérêt de se servir d’un média – le jeu vidéo – avec lequel ils sont naturellement à l’aise.» Liberté d'action A la manière de ce qui se passe dans The Sims, le programme développé par les chercheurs permet à l’adolescent de s’immerger dans la vie d’une famille se trouvant dans la même situation que la sienne. A lui dès lors d’envisager tous les scénarios possibles. «Nous avons évité une trop grande scénarisation afin de laisser une réelle liberté d’action au "joueur", poursuit la chercheuse. Il s’agit en effet de permettre au jeune d’expérimenter toutes sortes de cas de figure.» Autant de situations qui pourront ensuite servir de base de discussion au sein de groupes de parole formés d’experts et d’autres jeunes se trouvant dans le même cas. «Ces deux projets reposent sur l’idée, essentielle à nos yeux, que les nouvelles technologies ne constituent pas la solution unique à tous les maux, commente Mireille Betrancourt. Au contraire, ce type d’innovations ne peut être réellement efficace que si elles s’intègrent aux autres outils disponibles. Tout le défi consiste dès lors à orchestrer ces différents instruments pour que la partition finale soit la plus harmonieuse possible. L’objectif, c’est que l’ensemble des ressources mobilisées donne un tout cohérent.» |

Faits marquants

1981 > Lancement de l’IBM PC, l’ancêtre de la plupart des «PC» actuels . |

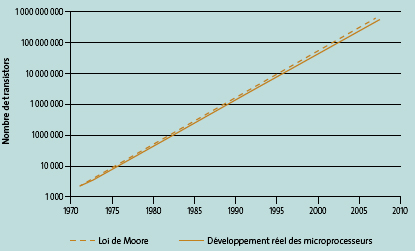

La «Loi de Moore»La «Loi de Moore» a été exprimée en 1965 dans la revue américaine Electronics Magazine par Gordon Moore, un des futurs fondateurs de l’entreprise de microprocesseur Intel. Constatant que la complexité des semi-conducteurs doublait tous les ans à coût constant depuis 1959, date de leur invention, Gordon Moore postule alors la poursuite de cette croissance. Dix ans plus tard, Gordon Moore corrigeait ce pronostic en prévoyant le doublement tous les deux ans du nombre de transistors composant un microprocesseur. Or, cette prédiction s’est révélée étonnamment exacte, puisque, entre 1971 et 2001, la densité des transistors a doublé chaque 1,96 année. C’est ce qui explique qu’en 2006, un ordinateur d’entrée de gamme était déjà 500 fois plus rapide, 32 000 fois plus puissant et 12 fois moins cher que le premier PC d’IBM, commercialisé vingt-cinq ans auparavant.

|