Dossier/les superordinateurs

Le calcul de haute performance se popularise à l’UNIGE

L’Université de Genève possède un superordinateur qu’elle partage avec l’Université et l’Ecole polytechnique fédérale de Lausanne. Plusieurs groupes disposent également de «grappes d’ordinateurs» de petite à moyenne puissance. Les sciences humaines font également leur entrée dans ce champ dominé par les sciences naturelles et médicales

Il faut vivre avec son temps. De plus en plus, les chercheurs, quelle que soit leur spécialité, se tournent vers les supercalculateurs, ces nouveaux outils dont la puissance de calcul augmente de manière vertigineuse d’année en année et dont l’usage se répand progressivement dans les universités. Autrefois réservés à quelques chercheurs spécialisés, les superordinateurs offrent en effet une nouvelle approche méthodologique dans de nombreux domaines, et pas seulement celui des sciences exactes. Même les sciences humaines devraient franchir le cap. C’est en tout cas l’avis de Bastien Chopard, professeur au Centre universitaire d’informatique (CUI), pour qui «modéliser» et «simuler» sont des termes qui devraient entrer dans le langage courant des académiciens, tout comme l’a fait le vocabulaire spécifique aux ordinateurs personnels et à Internet. Pour lui, les ordinateurs de «très haute performance», dont les meilleurs sont capables d’effectuer plus d’un million de milliards d’opérations par seconde, permettent d’aborder la science autrement, grâce à la restitution virtuelle des phénomènes étudiés. Une approche que l’on appelle in silico, en référence à la matière dans laquelle sont taillés les microprocesseurs.

Le plus rapide de l’Ouest helvétique

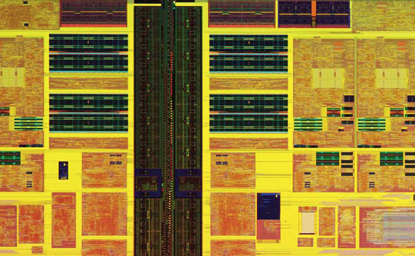

L’Université de Genève, comme ses consœurs, se fraye un chemin dans cette direction. Preuve en est la création récente de Cadmos (Center for Advanced Modeling Science), dont Bastien Chopard préside le Comité de direction. Il s’agit d’une coopération entre les Universités de Genève et de Lausanne ainsi que l’Ecole polytechnique fédérale de Lausanne (EPFL). Cette structure possède depuis août 2009 l’ordinateur le «plus rapide de l’Ouest» helvétique, un BlueGene/P d’IBM (lire ci-contre) dont les performances spectaculaires sont à la disposition des scientifiques des trois institutions lémaniques.

Afin d’encourager ses chercheurs à développer cette nouvelle approche, l’Université de Genève a nommé le Ier juin dernier Jean-Luc Falcone, collaborateur scientifique au CUI, au poste d’«analyste d’application HPC» (pour High Performance Computing). En langage commun, cela signifie qu’il jouera le rôle de conseiller et d’intermédiaire pour toutes les personnes intéressées par l’utilisation du BlueGene ou d’une autre «grappe d’ordinateurs» (cluster) de l’Université.

«L’idée est d’aider les chercheurs qui désirent se lancer dans la modélisation, explique-t-il. Il s’agit de leur fournir l’accès à cette méthodologie, les clés d’entrée d’une telle machine, les familiariser avec le code informatique, évaluer les véritables besoins en calcul de leur projet, les informer des limites du système, etc.»

Jean-Luc Falcone ne manquera sans doute pas de travail tant est grand le potentiel de croissance du nombre d’utilisateurs. A l’heure actuelle, même si l’Université de Genève compte dans ses rangs des pionniers et de fréquents utilisateurs des supercalculateurs, ils ne forment qu’une petite minorité. Sur la bonne quinzaine de projets retenus pour bénéficier de temps de calcul sur le BlueGene, seuls trois viennent ainsi du bout du lac. Les autres ont été proposés par des chercheurs de l’EPFL. Il faut dire que ces derniers sont habitués à considérer des applications qui nécessitent des ressources de calcul importantes et à utiliser les ordinateurs puissants disponibles sur le campus.

L’Université de Genève, elle, n’est pas dotée d’une puissance de calcul exceptionnelle. En plus du BlueGene, qui est installé à l’EPFL, elle possède des clusters de taille modeste à moyenne. Leur puissance de calcul suffit cependant aux besoins des groupes de recherche qui en disposent.

Centraliser les ordinateurs

«La politique actuelle de l’Université en la matière est de laisser chaque groupe acheter son cluster si nécessaire et l’équiper avec les logiciels de son choix, explique Bastien Chopard. Cette stratégie n’est cependant pas toujours la plus simple, puisqu’elle exige de la place. Tout le monde ne possède pas une ou plusieurs salles pour accueillir ces machines. C’est pourquoi la réflexion se poursuit sur la meilleure manière de procéder. Peut-être qu’il vaudrait mieux centraliser toutes ces grappes d’ordinateurs à un endroit. La distance entre les utilisateurs et le calculateur ne joue pas de rôle, puisque l’Université dispose de connexions rapides.»

Le cluster le plus puissant prévu à l’Université est celui de la Faculté de médecine dont le but sera de renforcer la plateforme VITAL-IT, pour les applications liées à la bio-informatique. Ce cluster comptera pas moins de 1000 cœurs – autrement dit, 1000 microprocesseurs travaillant en parallèle. Le Département d’informatique, quant à lui, vient d’acquérir un calculateur de 240 cœurs, dont l’usage sera réservé aux simulations de systèmes complexes. «Sa puissance est ajustée aux besoins de la plupart de nos projets», précise Bastien Chopard. Autres traditionnels amateurs de grande puissance de calcul, le Département d’astronomie et celui de physique nucléaire et corpusculaire possèdent chacun leur calculateur propre. A cela s’ajoutent plusieurs groupes disposant dans leur laboratoire de petits clusters contenant entre 8 et 32 cœurs.

Toutes ces (plus ou moins super-) machines offrent aux chercheurs une nouvelle manière de faire de la science. Elles permettent de simuler des phénomènes très divers et de réaliser des prédictions sans devoir passer par la réalité parfois trop coûteuse, parfois inaccessible. Le film accéléré d’une collision entre deux galaxies dans l’espace, par exemple, n’est pas un événement que l’on peut observer à l’envi. Un supercalculateur permet de le réaliser (bien qu’il faille réduire le nombre d’étoiles contenues dans les galaxies en question). Il permet également de proposer des scénarios probables pour expliquer les images figées que les astronomes observent aujourd’hui avec leurs télescopes.

De la même manière, grâce aux superordinateurs, il est possible, en un temps de plus en plus réduit et avec une précision de plus en plus grande, de simuler des phénomènes climatiques et météorologiques, l’écoulement du sang dans un vaisseau sanguin, le comportement d’une poche magmatique sous un volcan, l’effet probable d’une molécule sur une cible thérapeutique, les mécanismes d’une avalanche ou de l’explosion d’une arme à destruction massive.

Cela dit, les grandes puissances de calcul n’intéressent pas seulement les chercheurs en sciences naturelles et médicales. La finance est depuis longtemps une grande utilisatrice des supercalculateurs. Au début des années 2000, durant dix-huit mois, la machine la puissante de Suisse appartenait d’ailleurs à Credit Suisse.

Plus récent est l’intérêt des sciences humaines pour le calcul de haute performance. Luka Nerima, chargé d’enseignement au Laboratoire d’analyse et de traitement du langage (Faculté des lettres), par exemple, a participé l’année dernière à un projet international, PASSAGE 2, visant à évaluer un analyseur syntaxique du français. Pour l’analyse d’un corpus comptant plus de 200 millions de caractères (articles de presse et tirés de Wikipédia, l’encyclopédie en ligne ainsi que des textes littéraires), le chercheur a utilisé une dizaine d’ordinateurs fonctionnant en parallèle. Le travail a duré un jour au lieu de dix s’il n’avait utilisé qu’une seule machine.

«Jusqu’à récemment, ce genre d’ordinateurs de haute performance était trop cher pour les sciences humaines, estime Luka Nerima. Maintenant que leur usage se démocratise, nous les utilisons plus souvent. Et nous sommes intéressés à aller plus loin encore dans cette direction. Si nous avions accès à un Grid plus important, nous pourrions réduire encore le temps de calcul de nos analyses syntaxiques, ce qui est essentiel pour pouvoir améliorer nos outils informatiques.»

GlossaireFlops. Les flops sont une unité mesurant la performance d’un ordinateur. Il s’agit de l’acronyme anglais pour Floating Point Operations per Second, ou opérations à virgule flottante par seconde. Ces dernières comprennent toutes les opérations (additions, multiplications, soustractions et divisions) impliquant les nombres réels. En 1960, les performances des meilleurs ordinateurs atteignaient 250 kiloflops. Aujourd’hui, le record est de 1,76 petaflop, soit 7 milliards de fois plus. Cluster. Un cluster, ou grappe d’ordinateurs (parfois aussi appelé farm/ferme), est un ensemble d’ordinateurs reliés par des connexions très rapides fonctionnant comme un seul superordinateur ayant une plus grande capacité de stockage et une plus grande puissance de calcul. C’est la configuration idéale pour réaliser des calculs en parallèle. Chaque serveur d’une telle grappe, appelé nœud, peut effectuer une partie du calcul de son côté avant de communiquer ses résultats aux autres. Cœur. Jusqu’en 2005, les microprocesseurs n’étaient composés que d’un seul cœur: ils ne pouvaient lire et effectuer qu’une seule instruction à la fois. Aujourd’hui, les fabricants conçoivent des microprocesseurs contenant deux, quatre, six voire huit cœurs, c’est-à-dire autant d’unités de calcul indépendantes, reliées entre elles et compactées dans une seule puce. CPU. Le Central Processing Unit (CPU) est le composant de l’ordinateur qui exécute les programmes informatiques. Il s’agit donc d’un microprocesseur. GPU. Le Graphics Processing Unit (GPU)est un microprocesseur présent sur les cartes graphiques au sein d’un ordinateur ou d’une console de jeux vidéo. Il se charge des opérations d’affichage et de manipulation de données graphiques. Moins cher et moins gourmand en énergie, le GPU est cependant plus limité et plus spécialisé qu’un microprocesseur conventionnel. Il entre néanmoins de plus en plus souvent dans la conception des superordinateurs les plus rapides du monde. |

Un nuage plane sur le parc informatiqueRelier les ordinateurs personnels entre eux pour mettre en commun leur puissance de calcul est une stratégie très répandue et très prometteuse. L’Université de Genève participe à cet effort qui devrait aboutir à un «nuage de PC» genevois, voire suisses L’Université de Genève (UNIGE), en collaboration avec la Haute Ecole du paysage, d’ingénierie et d’architecture de Genève (Hepia), a pour projet de mettre en réseau la puissance de calcul de tous leurs ordinateurs personnels, ceux qui trônent dans les bureaux administratifs, les laboratoires et les salles informatiques des étudiants. Au total, plusieurs milliers de machines sont concernées. L’idée n’est pas nouvelle. Ces appareils ne fonctionnant que lors des heures de bureau, le reste du temps, la nuit ainsi que les samedi et dimanche, leur capacité de calcul dort alors qu’elle pourrait servir à l’avancement de la science. C’est pour exploiter ce potentiel que l’EZ-GRID, une infrastructure de calcul distribué, a été développée par le Centre universitaire d’informatique (CUI), la Division informatique de l’UNIGE et l’Hepia. Cent mille ordinateurs Le principe est le même que le Worldwide LHC Computing GRID (WLCG) élaboré par le CERN afin de stocker, traiter et analyser les montagnes de données fournies par les détecteurs de l’accélérateur de particules LHC. Le WLCG exploite en continu les performances de pas moins de plus de 100 000 microprocesseurs répartis sur 130 sites, eux-mêmes distribués dans 34 pays. Cette stratégie est particulièrement à la mode puisqu’une compagnie internationale très active dans la vente par correspondance de livres et de musique sur Internet a également décidé de mettre à disposition les ressources de ses énormes serveurs de commandes qu’elle possède à travers le monde. Ces derniers sont en effet inutilisés à des moments précis (la nuit, certaines heures de la journée lorsque le nombre de commandes est faible, etc.). Le service, dans ce cas, n’est en revanche pas gratuit. Maturité suffisante L’EZ-GRID, lui, est bien plus modeste. Il permet également d’utiliser les ressources de toutes les machines qui font partie du réseau dès qu’elles sont en veille. Le potentiel est tout de même assez important, puisque plusieurs milliers de PC sont répartis entre l’UNIGE et l’Hepia. Ce qui correspond à un supercalculateur comptant des milliers de microprocesseurs travaillant en parallèle. «Le système a atteint un stade de maturité suffisant et nous avons réalisé des projets tests sur quelques centaines de machines partagées entre l’Université et la Haute Ecole, précise Bastien Chopard, professeur au CUI. Si les résultats sont satisfaisants, il sera souhaitable que l’EZ-GRID se déploie sur le parc informatique de l’alma mater. Par ailleurs, toutes ces machines sont aussi reliées à un projet de réseau encore plus grand qui couvrirait toute la Suisse.» Le Swiss Multiscience Computing GRID (SMSCG) vise en effet à connecter des ordinateurs d’un grand nombre d’universités et hautes écoles du pays (www.smscg.ch). Quelques limitations Une telle infrastructure, bien que très puissante, bute néanmoins sur quelques limitations. «Dans le cadre de l’EZ-GRID, chaque ordinateur personnel est capable de faire des morceaux de calcul, mais il ne peut pas communiquer facilement avec les autres, précise Bastien Chopard. Ce genre de réseau est donc destiné à réaliser des calculs qui peuvent se séparer en un grand nombre de tâches indépendantes les unes des autres. Il ne peut dès lors pas se substituer à un superordinateur parallèle classique dans lequel les microprocesseurs échangent sans cesse des informations entre eux.» En d’autres termes, s’il s’agit de simuler l’effet d’un million de molécules différentes sur un même récepteur cellulaire, il serait judicieux de passer par l’EZ-GRID, chaque calcul étant indépendant des autres et pouvant être réalisé par une machine différente. En revanche, si l’on veut modéliser un écoulement sanguin dans une artère, où chaque élément de calcul a sans cesse besoin du résultat de plusieurs autres éléments de calcul, il est préférable de faire appel à un superordinateur ou une grappe d’ordinateurs (cluster) avec un réseau d’interconnexions très rapides. Il y a d’autres difficultés liées au déploiement d’une infrastructure de calcul distribué. Si, a priori, l’exploitation à des fins de calcul scientifique des parcs informatiques destinés aux étudiants ne pose pas de problèmes (puisque les appareils n’appartiennent à personne), la gestion administrative de ces postes et des salles où ils sont installés est souvent peu compatible avec les besoins de disponibilité requise pour EZ-GRID. En effet, l’électricité est parfois coupée dans certaines salles durant le week-end ou la nuit, ce qui empêche le «réveil à distance» des PC arrêtés. L’utilisation des appareils du personnel de l’Université serait dans ce sens plus aisée. En revanche, il n’est pas sûr que tout le monde soit d’accord de confier facilement son ordinateur aux techniciens de l’EZ-GRID. Certaines personnes pourraient craindre, en effet, que cette infrastructure n’entraîne des dysfonctionnements ou un ralentissement de leur machine, sans même parler du sentiment d’atteinte à leur sphère privée. Et ce, même si le projet contient, selon Bastien Chopard, toutes les garanties en matière de confidentialité et de sécurité. |

Les cartes graphiques: rapides et bon marchéUne des stratégies suivies par les constructeurs de supercalculateurs pour augmenter la puissance de leurs appareils consiste à exploiter les performances exceptionnelles des cartes graphiques. Développées à l’origine pour les jeux vidéo, ces cartes peuvent compter plusieurs centaines de microprocesseurs très puissants (GPU, pour Graphics Processing Unit). Une seule d’entre elles peut aujourd’hui atteindre une vitesse de calcul d’un teraflop (mille milliards d’opérations) par seconde. La différence entre ces petites cartes et les énormes supercalculateurs massivement parallèles, c’est que les premières sont spécialisées dans un type de calcul simplifié et ne peuvent de loin pas réaliser ce dont un microprocesseur traditionnel et moins rapide est capable. Il faut dire que leur usage premier est le traitement d’images graphiques, de vidéos et de rendus en trois dimensions. Certains chercheurs et fabricants de superordinateurs tentent d’exploiter ces propriétés à des fins de recherche scientifiques. C’est notamment le cas de la firme chinoise Dawning, qui a construit le superordinateur Nebulae, qui pointe à la deuxième place du dernier classement des ordinateurs les plus rapides du monde publié en juin 2010 (http://www.top500.org/). Cette machine possède probablement (les informations ne viennent pas directement du fabricant, pas très bavard, mais de spéculations de spécialistes) un tiers de GPU pour deux tiers de microprocesseurs conventionnels. |