L’ordinateur quantique est à la croisée des chemins

Il existe déjà des ordinateurs quantiques mais ils sont encore trop petits pour être capables de surpasser leurs homologues classiques. Le potentiel de telles machines est toutefois énorme. Les défis scientifiques et technologiques pour les développer le sont tout autant.

Depuis des décennies, la puissance des ordinateurs classiques suit une progression vertigineuse. Cela ne suffira cependant probablement jamais pour résoudre certains problèmes identifiés par les scientifiques et les ingénieurs. Qu’il s’agisse de factoriser un (très, très) grand nombre en nombres premiers, de prévoir la structure électronique et les propriétés dynamiques des molécules et matériaux complexes, de simuler un système quantique comprenant plus qu’une cinquantaine de particules libres ou encore d’optimiser le trajet du commis voyageur visitant un certain nombre de villes (problème emblématique de la théorie de la complexité), les machines classiques pourraient, en effet, ne jamais faire l’affaire. Il manque souvent la méthode, analytique ou numérique, pour venir à bout de ces systèmes complexes en des temps inférieurs à celui de l’âge de l’Univers.

Les ordinateurs quantiques, eux, pourraient y arriver. À condition bien sûr qu’ils atteignent un stade de développement technologique suffisant. Ce qui n’est pas encore le cas. « Nous nous trouvons à la croisée des chemins, estime Thierry Giamarchi, professeur au Département de physique de la matière quantique (Faculté des sciences). Il existe déjà des ordinateurs quantiques mais de taille encore très modeste. Le potentiel de ces machines est phénoménal. Les défis scientifiques et, surtout, technologiques à relever le sont cependant tout autant. »

Le principe de fonctionnement des ordinateurs quantiques diffère grandement des machines ordinaires. Tandis que la plus petite unité de stockage d’information classique est un « bit » valant 1 ou 0, son équivalent quantique est un « qubit ». Ce dernier, possédant des propriétés quantiques, n’a pas une valeur déterminée mais correspond à une combinaison, ou plus précisément une superposition, d’un 1 et d’un 0, chacune de ces deux valeurs étant, en plus, associée à un « poids », ou à une sorte de probabilité de survenir en cas de mesure. Le qubit vaut donc toutes les valeurs comprises entre 1 et 0 à la fois.

Un qubit tout seul ne sert à rien, pas plus qu’un bit d’ailleurs. Mais on peut en préparer plusieurs et les intriquer, ce qui, en langage quantique, signifie qu’ils sont fortement corrélés les uns avec les autres.

Dans le monde classique, une série de trois bits ne peut prendre qu’une seule valeur sur les huit possibles, telle « 101 ». Dans le monde quantique, en revanche, trois qubits intriqués sont décrits par une seule « fonction d’onde » qui contient toutes les valeurs possibles à la fois (000, 001, 010, 011, 100, 101, 110 et 111), chacune étant associée à une certaine probabilité. Cela signifie que le système quantique peut traiter toutes les possibilités simultanément. En augmentant le nombre de qubits, on augmente le nombre de combinaisons de manière exponentielle. Ainsi, un système quantique de 50 qubits compte plus d’un million de milliards de configurations possibles.

Massivement parallèle

« L’idée de génie est d’avoir imaginé agir sur un ensemble de qubits de telle manière à pouvoir effectuer un grand nombre d’opérations logiques en même temps, explique Thierry Giamarchi. C’est comme si l’on avait un ordinateur massivement parallèle. Dès que toutes les opérations, programmées par un algorithme spécial, sont achevées, le système, toujours intriqué, est décrit par une fonction d’onde sur laquelle on pourrait effectuer une mesure qui fournirait le résultat recherché. Cela représente une accélération gigantesque de la capacité de calcul. »

En théorie, même si le principe de fonctionnement est contre-intuitif, ça marche très bien. D’ailleurs, des chercheurs ont commencé à développer des logiciels quantiques avant même que le premier ordinateur de ce type ne voie le jour. L’un des premiers d’entre eux est celui du mathématicien américain Peter Shor qui a montré, en 1994, qu’un ordinateur quantique pourrait casser la clé de cryptage la plus sophistiquée de l’époque en un temps raisonnable (une réussite précoce qui a d’ailleurs immédiatement dopé l’intérêt pour la cryptographie quantique qui, elle, est à l’épreuve de n’importe quel ordinateur quantique).

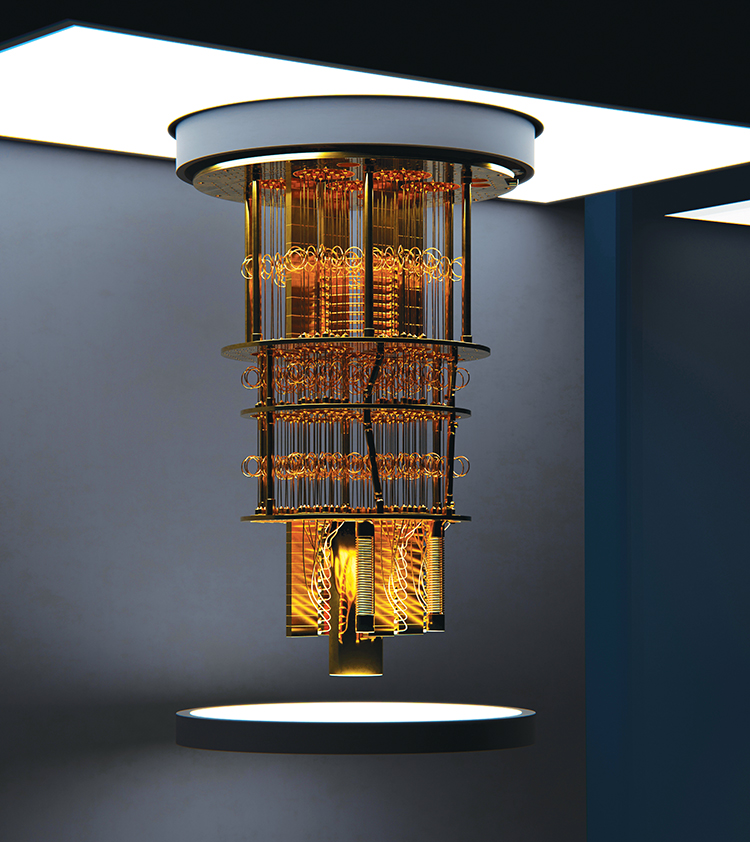

En pratique, c’est un peu plus compliqué. Le premier défi, et pas des moindres, consiste à fabriquer des qubits. Plusieurs voies sont explorées : des systèmes avec des ions piégés, avec des semi-conducteurs, avec des supraconducteurs, etc. L’essentiel consiste à avoir des « objets » assez petits et assez froids pour pouvoir révéler leur nature quantique et l’exploiter. Ces qubits, qu’il s’agisse d’atomes froids ou de jonction supraconductrice, doivent aussi être intriqués de manière à former un objet unique ou cohérent.

« Or, le plus grand ennemi d’un ordinateur quantique est la décohérence, souligne Thierry Giamarchi. Aucun système, aucune opération, n’est parfait. Il y a des sources de bruits extérieures (des ondes essentiellement) que l’on ne maîtrise pas. Et le problème, c’est qu’une fonction d’onde qui comprend beaucoup de qubits intriqués entre eux est incroyablement fragile. La moindre perturbation ou la moindre erreur dans le dispositif lui-même risque de provoquer sa décohérence et de rendre toute l’opération de calcul caduque. »

Le paradoxe, c’est qu’il faut à la fois protéger les qubits de l’influence extérieure afin de conserver leur intégrité et pouvoir les manipuler individuellement, avec un laser, un champ magnétique ou un courant électrique infime, afin d’effectuer des opérations logiques.

Avantage quantique

Il existe déjà des prototypes d’ordinateur quantique. Leur puissance de calcul, par contre, n’a pas encore convaincu la communauté scientifique. Le Sycamore de Google est probablement l’une des machines les plus abouties à ce jour. Il est formé d’un processeur de 54 qubits supraconducteurs (dont un défectueux). Selon l’article qui le présente, paru dans la revue Nature du 23 octobre 2019, le Sycamore aurait réalisé en 200 secondes une tâche qui aurait pris 10 000 ans au meilleur supercalculateur classique de la planète. IBM, le grand rival de Google dans la course à l’ordinateur quantique, a immédiatement répondu que cette tâche – sans intérêt scientifique mais spécialement adaptée au fonctionnement d’un ordinateur quantique – pouvait en fait être réalisée en quelques jours seulement avec un microprocesseur classique à condition d’utiliser le bon logiciel.

« Ce qui a vraiment écorné l’annonce de Google, c’est le travail d’une équipe de l’Université de Grenoble, précise Thierry Giamarchi. Ces chercheurs ont en effet montré que si le résultat du calcul effectué par le Sycamore avait été très précis, Google aurait eu raison de revendiquer ce qu’on appelle de manière peu élégante la « suprématie quantique », un terme auquel je préfère « avantage quantique ». Mais, en réalité, le résultat publié est entaché d’une certaine marge d’erreur. Du coup, si on accepte une telle imprécision, alors on peut effectuer la même tâche plus rapidement avec un ordinateur portable et un logiciel très bien conçu. »

Car un autre problème inhérent aux ordinateurs quantiques est celui de la correction d’erreurs, lesquelles peuvent survenir à tout moment dans le processus de calcul. À cause des propriétés de la mécanique quantique, il est impossible de copier une fonction d’onde afin de la mettre en mémoire. Les ingénieurs ont donc dû se résoudre à consacrer, pour chaque qubit fonctionnel, un certain nombre de qubits supplémentaires destinés à la seule correction de ces erreurs.

Le Sycamore n’est pas le seul prototype d’ordinateur quantique. De son côté, IBM développe une machine concurrente (Quantum System One) qui comptait 27 qubits en 2019. Une équipe chinoise a également présenté un ordinateur quantique « photonique », le Jiuzhang, de 76 qubits dans la revue Science du 18 décembre 2020. L’une des limites de cette dernière machine, cependant, est qu’elle est conçue pour n’effectuer qu’un seul type de tâche tandis que l’ordinateur quantique de Google pourrait être programmé pour exécuter une variété d’algorithmes.

Plusieurs laboratoires disposent par ailleurs de leurs propres machines ou plateformes quantiques. L’École polytechnique fédérale de Zurich, par exemple, utilise actuellement des calculateurs quantiques comptant jusqu’à 17 qubits. Elle et l’Institut Paul Scherrer ont créé cette année un Quantum computing hub dont l’objectif est le développement d’un ordinateur quantique de 100 qubits.

« La recherche dans ce domaine, scientifique autant que technologique, avance vraiment rapidement, note Thierry Giamarchi. Si on arrive à doubler (au grand minimum) le nombre de qubits par rapport à ce qui se fait de mieux aujourd’hui, à les rendre le plus robustes possible, à bien corriger les erreurs, alors les ordinateurs quantiques devraient pouvoir faire la preuve de leur utilité, à savoir résoudre des problèmes intéressants. J’ignore si l’effort international consenti dans ce domaine accouchera un jour d’un véritable ordinateur quantique qui tienne toutes ses promesses. En revanche, je suis sûr qu’il en sortira de toute façon quelque chose de très intéressant, peut-être pour d’autres applications dont nous n’avons encore aucune idée. »

Le succès monumental des « simulations quantiques »Les promesses de l’ordinateur quantique occultent souvent une technologie alternative, appelée les « simulations quantiques », qui, contrairement au premier, a déjà engrangé quelques résultats notables. |